バラ積みピッキングのための高速3次元物体位置姿勢認識技術の確立

- ビンピッキング

- 3次元認識

- 位置合わせ

- 3Dセンサ

- ロボット

製品の組立工程には、コンテナ内に無造作に積まれた部品を自動機へ供給する作業がある。これはバラ積みピッキングと呼ばれる。近年の製造現場での人手不足や人件費高騰の深刻化を受け、同作業の自動化が求められている。3Dセンサと産業用ロボットを用いてバラ積みピッキングを実現することにより、同一システムで多品種の生産に対応でき、生産ライン立ち上げのコストと工数の削減が可能となる。このとき、人と同等の速度を実現するためには、3次元空間上での部品の位置姿勢を高速かつ高精度に認識できる技術が重要となる。本研究では、粗密探索と詳細位置合わせからなる3次元物体位置姿勢認識技術を提案する。粗密探索では PCOF-MOD特徴量と平衡姿勢探索木を用いて、物体の大まかな位置姿勢を高速に推定する。詳細位置合わせではデプス画像とRGB画像を用いて、3次元空間と2次元空間の最適化を行うことにより、高精度な位置姿勢推定を実現する。提案手法を評価したところ、従来手法と比較し位置姿勢の推定精度が約2倍向上していることを確認した。また、提案手法を用いた認識時間はIntel® Core i7-7700@3.60GHzのCPUを搭載した計算機で平均146.2 msであり、速度と精度が両立できていることを確認した。

1. まえがき

近年、製造現場での人手不足や人件費の高騰が深刻化し、人に依存している組立・検査・搬送工程などの自動化が急務となっている。製品の組立時の部品供給工程においては、部品供給を自動化する方法の一つとして、パーツフィーダーと呼ばれる部品を供給するための専用の装置を使用する方法がある。しかし、パーツフィーダーは部品毎で専用に設計される特注品であるため、品種数に応じて設計が必要となり生産ライン立ち上げのコストや工数が増加する課題がある。また、大きな部品や傷つきやすい部品には対応できず扱える部品が限られるという課題もある。そこで、コンテナ内に無造作に積まれた様々な形状の部品を自動機へ供給する、いわゆるバラ積みピッキング作業の自動化が求められている。3Dセンサと産業用ロボットを用いてバラ積みピッキングが実現できれば、これらの課題を解決できる。

バラ積みピッキングを実現するための一般的な処理の流れは、①3Dセンサで部品のRGB-D画像を取得し、②同画像に部品の3次元CADから生成したモデルをマッチングさせることで部品の位置姿勢を認識し、③その認識結果に合わせて部品を安全に把持できるロボットハンド位置を算出し、④算出した位置にロボットを動作させ部品を把持する、という流れである。これらの処理のうち3Dセンサや画像処理コントローラが担う処理は①~③である。製造現場で人と同等な性能でバラ積みピッキングを実現するためには、②の物体の位置姿勢認識が特に重要であり、本研究では高速かつ高精度な3次元物体位置姿勢認識技術を提案する。

2. 関連研究

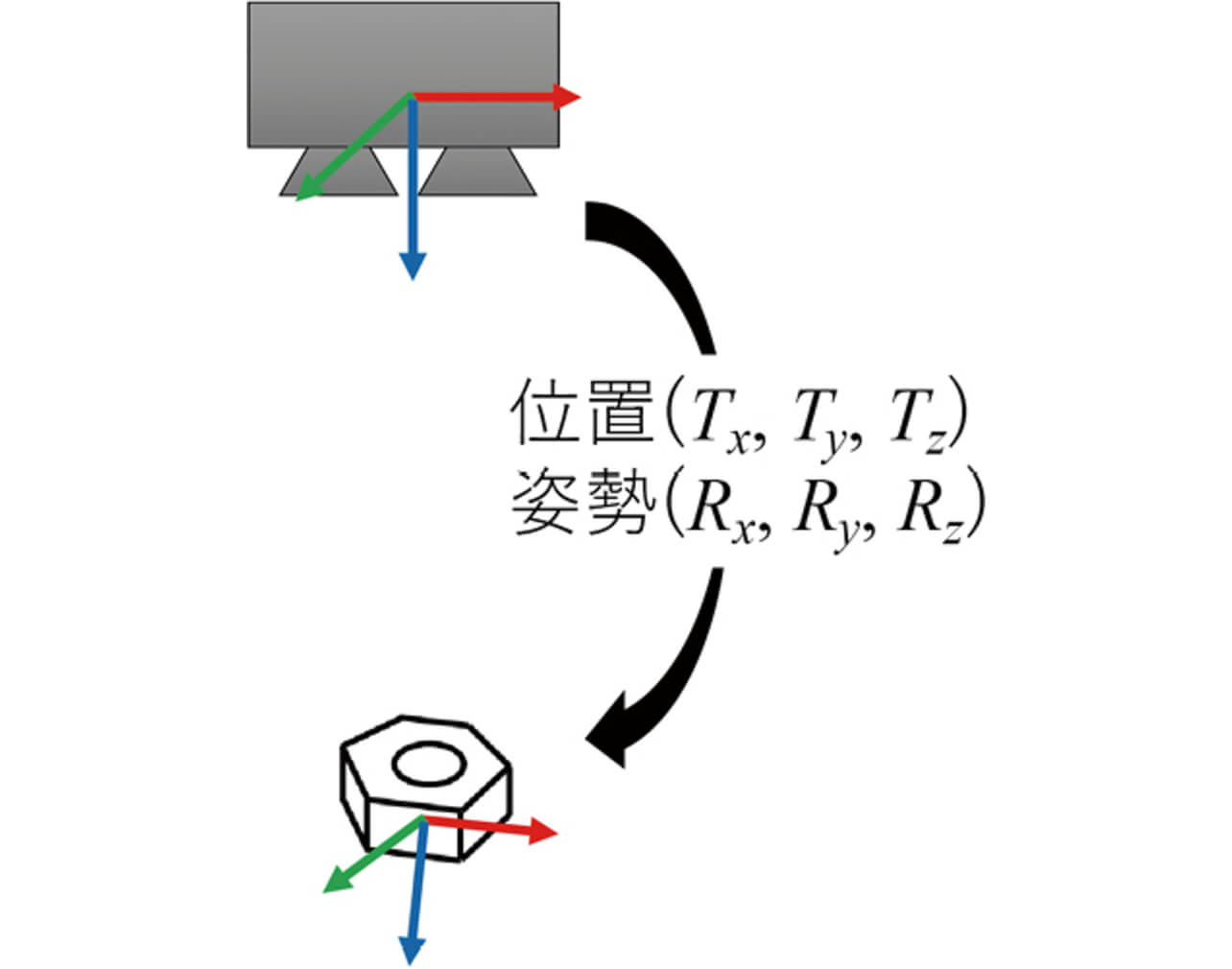

3次元物体位置姿勢認識とは、3Dセンサから見た部品の3次元空間上での位置姿勢(並進Tx 、Ty 、Tz 及び回転Rx 、Ry 、Rz の6パラメータ)を推定する技術である(図1)。

これまで提案されてきた3次元物体位置姿勢認識手法は大きく二つに分類することができる。一つは3次元点群に基づく手法1)-5)、もう一つは2次元投影画像に基づく手法6)-14)である。

2.1 3次元点群に基づく手法

3次元点群に基づく手法は、3次元CADなどから生成した部品のモデルと入力データの照合に基づき、モデルと入力データの整合性が高い位置姿勢を探索する手法である。モデルを生成する手法としては周辺点群との位置関係を記述したspin image1)やキーポイント周辺点群の法線方向ヒストグラムを利用したFPFH2)やSHOT3)、2点間の関係性を記述したPPF4)5)と言った手法が知られている。これらの手法は処理速度が遅く、また物体の背景が複雑な場合に頑健性が低いことが指摘されている6)。

2.2 2次元投影画像に基づく手法

2次元投影画像に基づく手法では、様々な視点から物体を見たときのRGB画像とデプス画像を用いて特徴量を抽出したテンプレートを予め作成しておき、新規に計測した画像をそれらと照合することで位置姿勢を推定する。手法としては、局所テンプレート照合と一般化ハフ変換を組み合わせた手法7)-9)や、部品全体のテンプレートを用いて画像内を走査する手法6)10)11)がある。前者は、6次元の投票空間から最頻値を探索する処理に時間が掛かる課題がある。後者は、姿勢の変化による物体のあらゆる見え方についてテンプレートを作成し走査する必要があるため、物体の種類や画像解像度が増加した場合に処理時間が線形的に増加するという課題があった。それに対して、量子化した特徴量であるLINEMOD12)やPCOF13)やPCOF-MOD14)を用いることで、位置姿勢を高速に認識出来ることが示されている。特にPCOF-MODは部品の輪郭と表面の二つの情報を用いた特徴量であり、他の手法に比べて認識率が高いことが示されている14)。

また、物体と背景を識別する2クラス識別器を学習させることで背景が複雑な場合に対する頑健性を高める研究もされてきたが15)16)、背景データを対象物体や撮像環境毎に集めるのは非常に煩雑であるため、物体の3次元CADのみから認識に必要なテンプレートなどを含むモデルを作成できることが望ましい。

これらを踏まえ本研究では、製造現場の実アプリケーションに適用可能な使い勝手と速度・精度を備えた3次元物体位置姿勢認識手法として、テンプレートマッチングに基づく手法を用いる。

3. 3次元物体位置姿勢認識手法

速度と精度を両立した3次元物体位置姿勢を実現するために、物体の大まかな位置を高速に探索する粗密探索と、推定精度向上のための詳細位置合わせからなる手法を検討する。粗密探索では高速性と認識率の観点からPCOF-MOD特徴量と平衡姿勢探索木を用いた手法を採用する。詳細位置合わせでは、製造現場に存在する単純形状の部品に対しても高い位置姿勢推定精度を実現するために、デプス画像とRGB画像を併用した位置合わせ手法を提案する。

3.1 粗密探索

粗密探索ではPCOF-MOD特徴量を用いたテンプレートに対して、平衡姿勢探索木14)を用いた照合処理を行うことで物体の大まかな位置姿勢を高速に算出する。

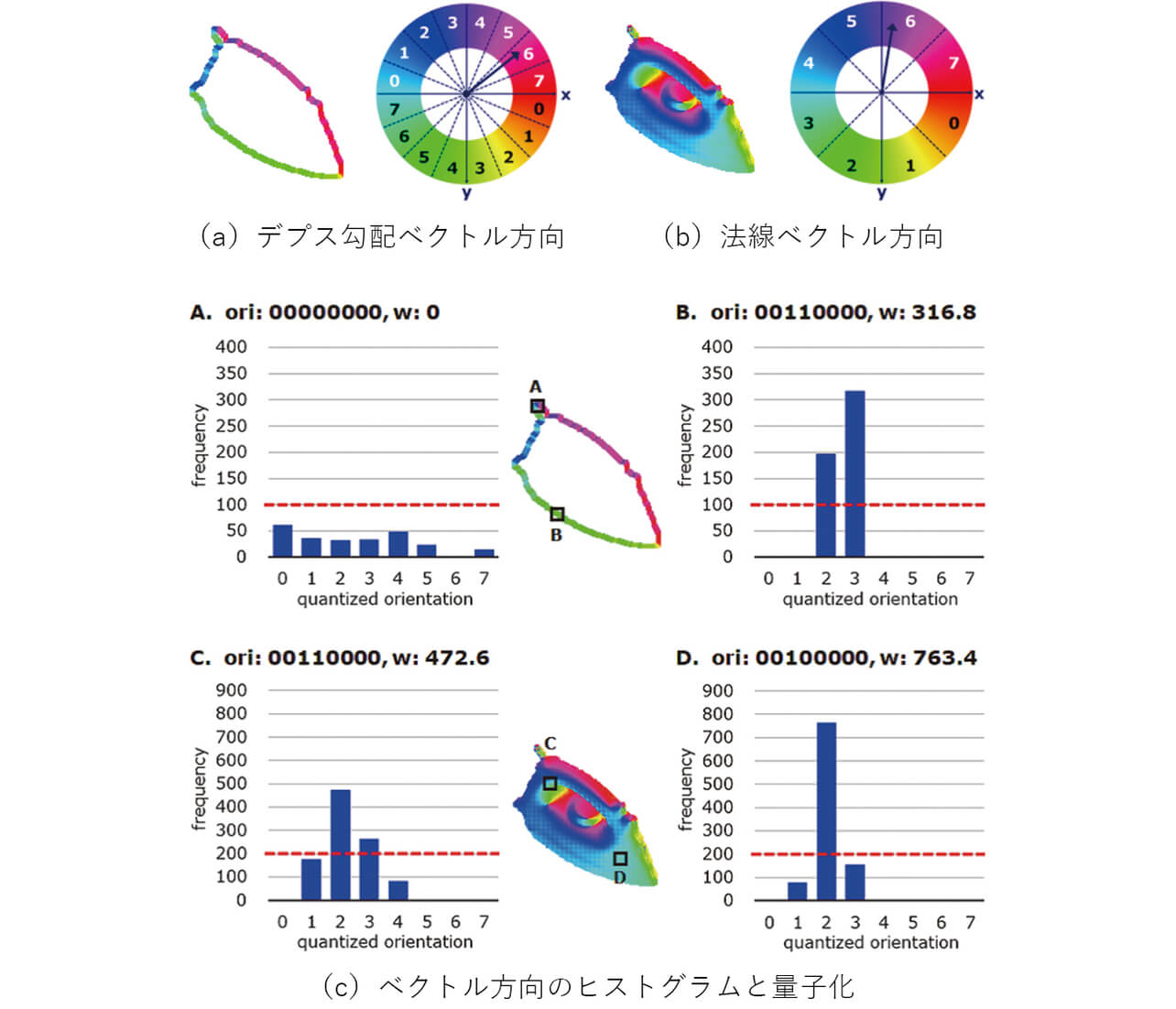

PCOF-MOD(Perspectively Cumulated Orientation Feature Multimodal)は物体の姿勢変化による見え方の変化に対し、許容できる物体の見え方のバリエーションと複雑背景に対する頑健性を両立させた特徴量である。テンプレート作成では物体の姿勢を変化させた複数枚のデプス画像を用いて、物体の輪郭特徴を表すデプス勾配ベクトルと、物体の表面特徴を表す法線方向ベクトルを抽出する。そして、画素毎に勾配方向ヒストグラム及び法線方向ヒストグラムを作成し、各画素のヒストグラムに対して頻度閾値以上の方向のみ選択し対応するビットを1にした8桁の二進数をPCOF-MOD特徴量として抽出する(図2)。

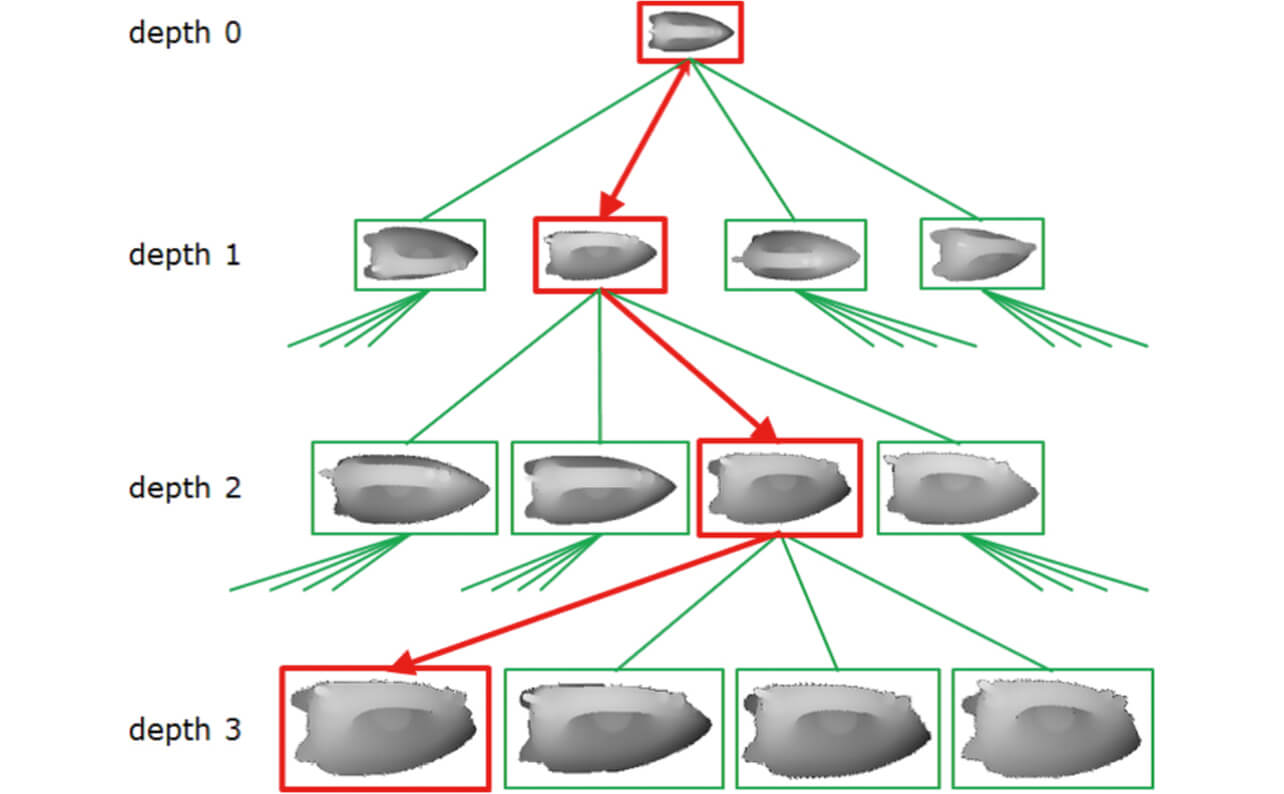

平衡姿勢探索木は解像度の異なるテンプレート階層で構成された探索木であり、各テンプレートの探索効率が均一になるように階層の深さや親ノードに連結する子ノードのテンプレート数ができるだけ均一になるように構成されている。照合処理では画像ピラミッドの最も低解像度の階層に対して、平衡姿勢探索木の親ノードのテンプレートを用いて画像上を走査し候補を検出する。さらに候補が見つかった座標に対しては画像ピラミッドの解像度を上げ子ノードのテンプレートを用いて詳細な照合を繰り返すことにより、画像上での物体の位置を高速に算出する(図3)。

最後に物体の3次元CAD上の3次元座標と入力画像上での2次元座標との対応関係を用いてPnP問題を解く17)ことにより物体の大まかな位置姿勢が推定できる。

3.2 詳細位置合わせ

粗密探索で推定した位置姿勢は2次元の投影画像に基づいているため、画像平面での変化に現れにくい奥行方向の位置(Tz )と傾き(Rx 、Ry )に対しては精度が低い。そこで、位置姿勢推定精度向上のための詳細位置合わせを行う。

3次元空間上での位置合わせ方法としては、3次元CADから生成した点群とデプス画像から得た計測点群にICP(Iterative Closest Point)アルゴリズム18)を適用して行う方法が一般的である。しかし、デプス画像のみを使ったICPでは、複数の平面で構成されているような単純形状の部品(図7のホルダーなど)が無造作に積まれたことで一部の平面しか見えないような姿勢において画像平面上での変化に相当する並進(Tx 、Ty )と回転(Rz )の推定が困難であり、位置姿勢の推定精度が低下する課題がある。製造現場ではこのホルダーのように、主に平面で構成される単純形状の部品も多く存在する。そこで、平面しか見えない場合でも高い位置姿勢の推定精度が得られる詳細位置合わせ手法を提案する。

RGB-D画像を用いた位置合わせを行う際の特徴として、RGB画像は画像平面での位置(Tx 、Ty )と回転(Rx )の推定精度が高く、デプス画像は奥行方向の位置(Tz )と傾き(Rx 、Ry )の推定精度が高い。そのため、提案手法では両者を相補的に用いることで位置精姿勢推定精度の向上を図る。

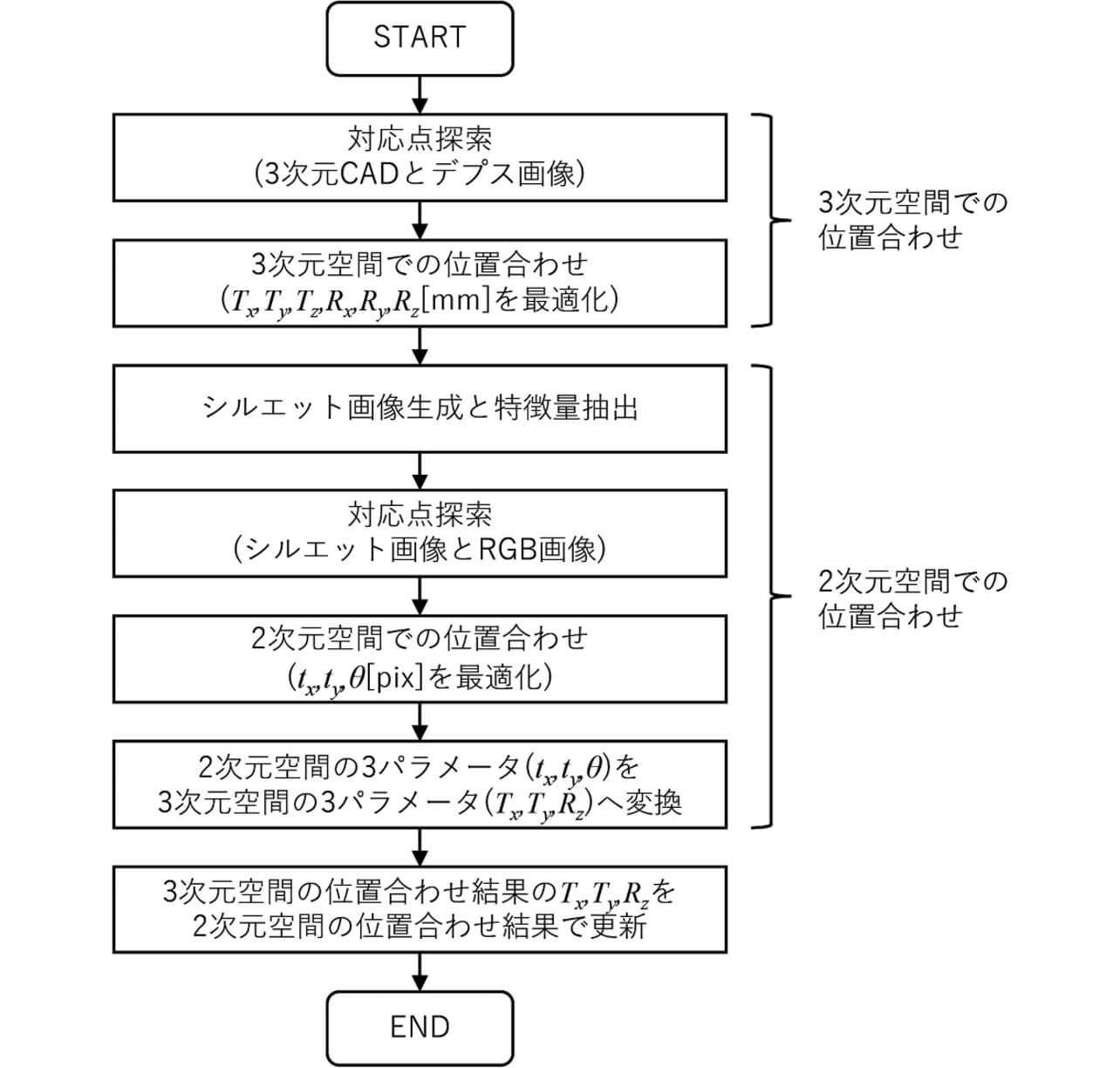

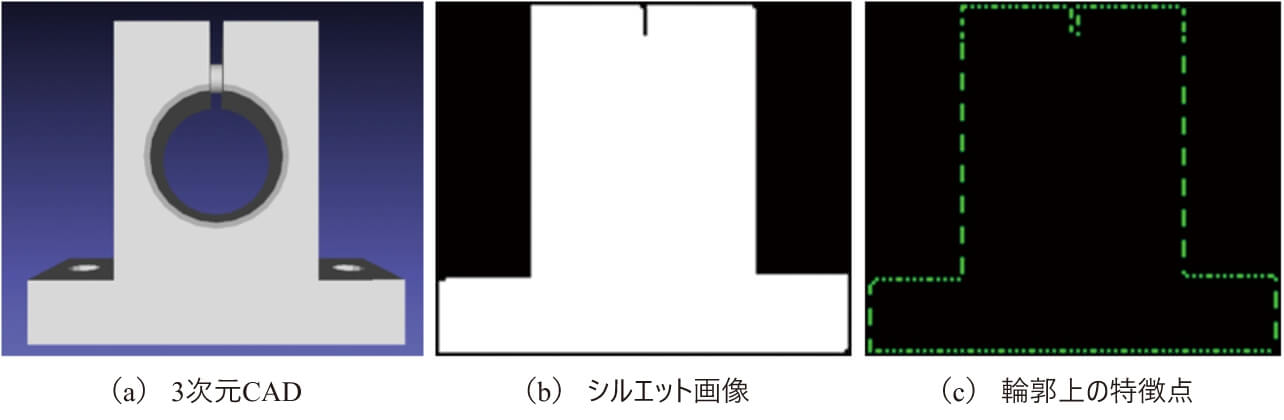

デプス画像とRGB画像を使った詳細位置合わせの処理の流れは図4の通りであり、3次元空間上での位置合わせと2次元空間上での位置合わせをそれぞれ実施し、最後に互いの推定結果を統合する流れである。まず、粗密探索で得られた位置姿勢と、テンプレート作成時に予め生成した3次元CAD上の点群と、デプス画像の計測点群を入力としてICPによる3次元空間上での位置合わせを行う。次に、3次元空間上でのICPで算出した位置姿勢を用いて3次元CADを画像平面に投影したシルエット画像を作成し、その画像に対してSobelフィルタを用いたエッジ抽出により輪郭上の特徴点を算出する(図5)。次に、RGB画像に対して同様の方法でエッジ抽出した画像とシルエット画像の特徴点を重ね合わせ、特徴点の近くにあるRGB画像のエッジ特徴を探索することにより、特徴点の対応関係を算出する。この対応関係から、2次元空間上でのICPを行うことで画像平面上での並進tx 、ty と回転θ を推定し、PnP問題を解くことにより画像平面で最適化したTx 、Ty 、Rz を算出する。最後に、3次元空間上でのICPで算出した位置姿勢のTx 、Ty 、Rz をこれらで置き換えることにより、3次元空間と2次元空間で最適化した位置姿勢を得ることができる。

4. 評価実験

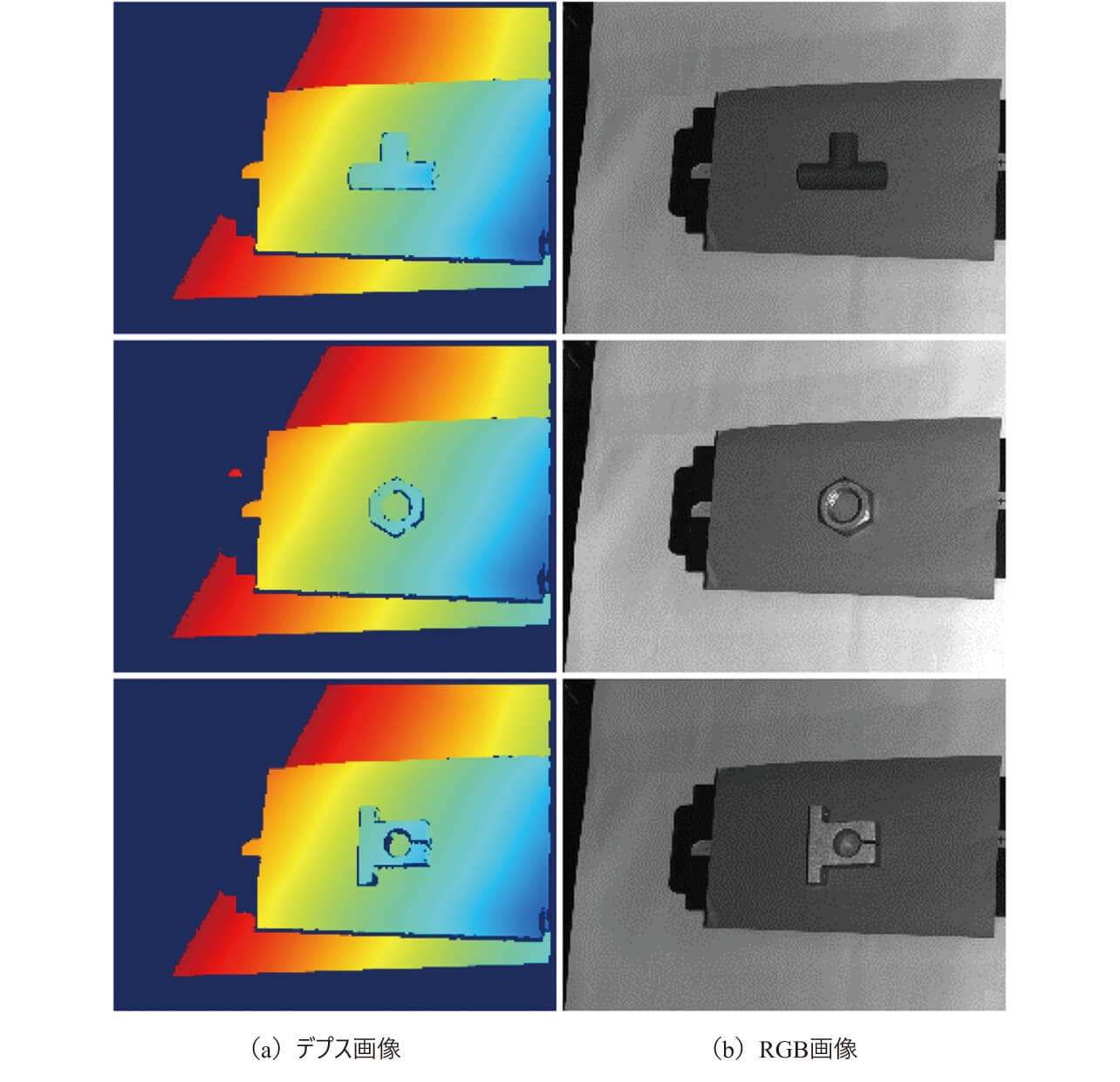

製造現場における産業用ロボットの把持タスクを想定し、リニアリティ評価データセットを用いた位置姿勢の推定精度の評価(実験1)とバラ積み部品データセットを用いた認識率と処理時間の評価(実験2)を行うことにより、提案手法の有効性を検証する。データセットの撮影には自社で開発した3Dセンサである形FH-SMDA-GS050B(図6)のプロトタイプ機を使用し、グレースケール画像とデプス画像を撮像した。処理時間はIntel(R)Core i7-7700@3.60GHzのCPUを搭載した計算機で計測した。

4.1 実験1 位置姿勢推定精度評価

実験1では位置姿勢の推定精度に対する提案手法の有効性を評価するために、静止繰り返し精度とリニアリティ精度を評価した。

静止繰り返し評価では、平面や曲面で構成された3種類の部品(図7)と3Dセンサの位置関係を固定し、3Dセンサと部品が正対している姿勢を基準として3通り(傾き無し、Y軸のみ傾きあり、X軸とY軸に傾きあり)の姿勢にて、50枚の計測データを連続撮像したデータセットを用いる。推定した位置姿勢の6パラメータに対して、標準偏差を算出することで部品の位置姿勢が変動していないかを評価した。

リニアリティ評価では部品をXステージに乗せて計測の度に既定の距離だけ移動させる撮影方法にて、3Dセンサの姿勢を3通り、部品の移動方向を2通り(画像上で横方向移動、画像上で斜め方向移動)にて、移動量の刻みは2 mmで撮像の度に部品の位置を移動させながら100枚の計測データを取得したデータセットを用いる。リニアリティ評価では、推定された位置姿勢より、3Dセンサ原点から部品の外接立方体の8個の頂点までの距離を算出し、各データ間での8点の移動量とステージの移動量の差分値を算出することで位置姿勢の推定結果に線形性があるかを評価した。

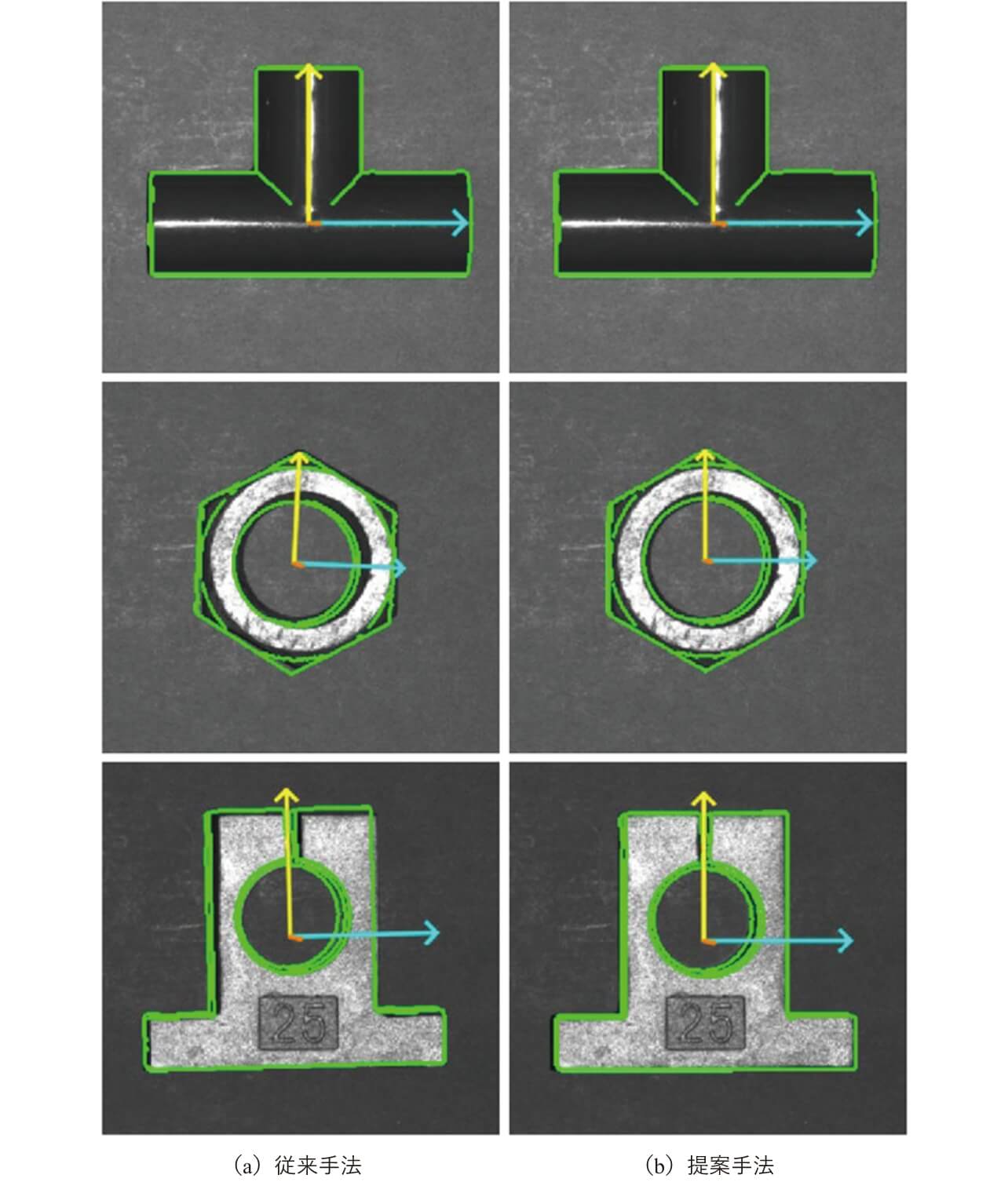

PCOF-MOD特徴量と平衡姿勢探索木を用いた粗密探索後にデプス画像のみによる詳細位置合わせを行う従来手法14)と提案手法の性能を比較した。静止繰り返し評価の結果を表1、表2、リニアリティ評価の結果を表3にそれぞれ示す。従来手法と提案手法の認識結果画像例を図8に示す。評価より従来手法と比較し平均で約2倍の位置合わせ精度の向上が確認できた。特にナットやホルダーなど特定の視点から見ると平面部分しか見えないような3次元的な形状特徴が少ない部品に対して提案手法を用いた場合の改善効果が高く、図8の位置合わせ結果画像からも従来手法では画像平面方向に並進ずれや回転ずれを起こしているのに対して、提案手法では改善されていることが確認できる。

| 部品 | 従来手法 | 提案手法 |

|---|---|---|

| パイプ | 0.028 | 0.023 |

| ナット | 0.207 | 0.065 |

| ホルダー | 0.116 | 0.064 |

| 平均 | 0.117 | 0.051 |

| 部品 | 従来手法 | 提案手法 |

|---|---|---|

| パイプ | 0.027 | 0.036 |

| ナット | 0.386 | 0.239 |

| ホルダー | 0.101 | 0.067 |

| 平均 | 0.171 | 0.114 |

| 部品 | 従来手法 | 提案手法 |

|---|---|---|

| パイプ | 0.054 | 0.074 |

| ナット | 0.687 | 0.164 |

| ホルダー | 0.712 | 0.250 |

| 平均 | 0.485 | 0.162 |

4.2 実験2 認識性能評価

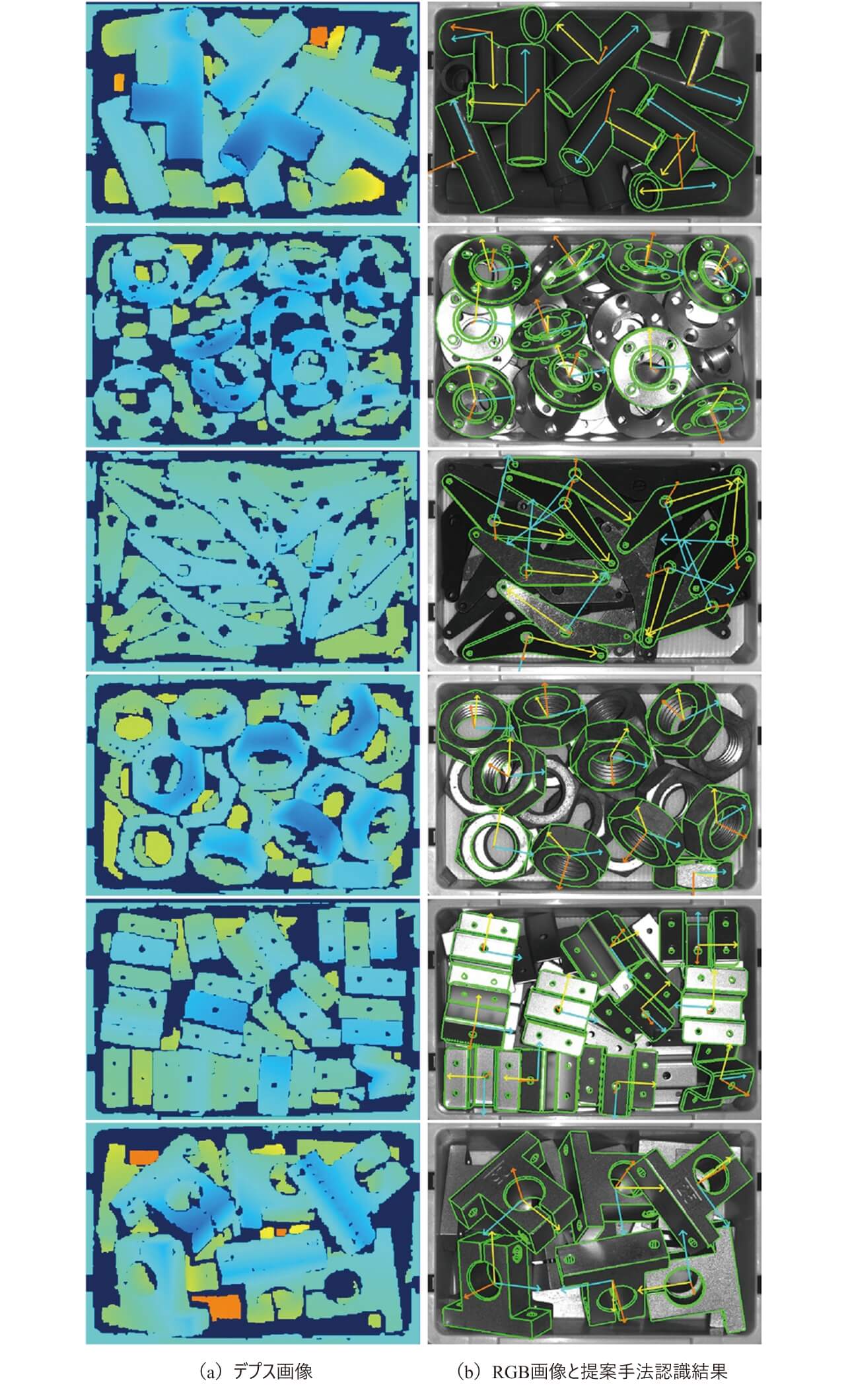

実験2では提案手法の詳細位置合わせにより認識率と処理速度の大幅な低下がないことを確認するために、コンテナの中にバラ積みされた平面や曲面を含む6種類の部品データセット(図9)を作成し認識率と処理時間を評価した。データセットは各部品についてバラ積みパターンを変更した20枚の計測データを取得した。各バラ積みデータの上部に露出している部品に対して、目視による初期位置姿勢の入力とICPによる位置合わせを組み合わせることでデータセットに対する位置姿勢の正解値を算出した。1枚あたり5~10個の部品が上部に露出しており、部品の隠れた領域の表面積が部品全体の15%以下ものを認識対象とし、部品あたりの評価母数は100~200個程であった。

PCOF-MOD特徴量と平衡姿勢探索木を用いた粗密探索後にデプス画像のみによる詳細位置合わせを行う従来手法14)と、提案手法と同じく3次元CADのみを用いて認識に必要なモデルデータを作成可能な手法としてPPF(Point-Pair Feature)と一般化ハフ変換に基づく手法4)と、提案手法との比較をした。PPFの実装として商用マシンビジョンライブラリであるHALCON13の関数「Surface-based Matching」を用いた。なお認識対象範囲はコンテナの内部のみ(画像上で700×400画素程度)とした。認識性能評価には、推定された位置姿勢と正解値との誤差絶対値に基づいてPrecision、Recall、F値を算出した。バラ積みデータセットの正解値を人手で入力していることも考慮し、認識成功の基準閾値は並進が5 mm以内、回転角度が7.5°以内とした。部品毎及び全体の平均F値を表4に平均処理時間を表5にそれぞれ示す。

| 部品 | PPF | 従来手法 | 提案手法 |

|---|---|---|---|

| パイプ | 0.825 | 0.942 | 0.946 |

| リング | 0.754 | 0.977 | 0.967 |

| リンク | 0.355 | 0.915 | 0.908 |

| ナット | 0.819 | 0.981 | 0.981 |

| 金属シート | 0.572 | 0.888 | 0.879 |

| ホルダー | 0.908 | 0.989 | 0.989 |

| 平均 | 0.706 | 0.949 | 0.945 |

| 部品 | PPF | 従来手法 | 提案手法 |

|---|---|---|---|

| パイプ | 1423.9 | 92.1 | 112.2 |

| リング | 1736.2 | 106.0 | 129.1 |

| リンク | 1066.2 | 186.6 | 204.2 |

| ナット | 1883.4 | 118.1 | 134.9 |

| 金属シート | 2376.7 | 171.0 | 192.1 |

| ホルダー | 591.8 | 97.5 | 104.7 |

| 平均 | 1513.0 | 128.5 | 146.2 |

評価結果から提案手法と従来手法の認識率は同等であることが確認できた。また、処理時間は提案手法と比較して18 ms程度遅くなっているが、バラ積みピッキングのアプリケーション自体が数十msを争うものではないため、実用上問題のない範囲であると考えられる。

5. むすび

本研究では、製造現場の部品供給の自動化を実現するために、多種多様な部品に対して高速かつ高精度に3次元空間上での位置姿勢を推定できる手法を提案した。

粗密探索では PCOF-MOD特徴量と平衡姿勢探索木を用いて、物体の大まかな位置姿勢を高速に推定した。詳細位置合わせではデプス画像とRGB画像を併用することで高精度な推定を実現した。評価用データセットを構築し性能を評価した結果、既存手法と比較して位置姿勢の推定精度が約2倍向上できていることを確認した。

位置姿勢認識の今後の課題としては、外形は似ているが部品の一部分だけ形状が微小に異なるような類似部品が混在するバラ積み状態に対しても部品の識別を含めたピッキングをできるようにするため、特徴量の追加などの改善が挙げられる。

参考文献

- 1)

- Johnson, A.; Hebert, M. Using Spin Images for Efficient Object Recognition in Cluttered 3D Scenes. IEEE Transactions on Pattern Analysis and Machine Intelligence. 1999, Vol.21, p.433-449.

- 2)

- Rusu, R.B.; Blodow, N.; Beets, M. “Fast Point Feature Histograms(FPFH)for 3D Registration”. IEEE International Conference on Robotics and Automation. 2009, p.1848-1853.

- 3)

- Tombari, F.; Salti, S.; Stefanob, L. D.; “Unique Signatures of Histograms for Local Surface Description”. European Conference on Computer Vision. 2010, p.356-369.

- 4)

- Drost, B.; Ulrich, M.; Navab, N.; Ilic, S. “Model Globally, Match Locally: Efficient and Robust 3D Object Recognition”. IEEE Computer Society Conference on Computer Vision and Pattern Recognition. 2010, p.998-1005.

- 5)

- Hinterstoisser, S.; Lepetit, V.; Rajkumar, N.; Konolige, K. “Going Further with Point Pair Features”. European Conference on Computer Vision. 2016, p.834-848.

- 6)

- Hinterstoisser, S.; Lepetit, V.; Ilic, S.; Holzer, S.; Bradski, G.; Konolige, K.; Navab, N. “Model Based Training, Detection and Pose Estimation of Texture-Less 3D Objects in Heavily Cluttered Scenes”. Asian Conference on Computer Vision. 2012, p.548-562.

- 7)

- Brachmann, E.; Krull, A.; Michel, F.; Gumhold, S; Shotton, J; Rother, C. “Learning 6D Object Pose Estimation using 3D Objecto Cordinates”. European Conference on Computer Vision. 2014, p.536.

- 8)

- Tejani, A.; Tang, D.; Kouskouridas, R; Kim, T.K. “Latent-Class Hough Forests for 3D Object Detection and Pose Estimation”. European Conference on Computer Vision. 2014, p.462-477.

- 9)

- Kehl, W.; Milletari, F.; Tombari, F.; Ilic, S.; Navab, N. “Deep Learning of Local RGB-D Patches for 3D Object Detection and 6D Pose Estimation”. European Conference on Computer Vision. 2016, p.205-220.

- 10)

- Kehl, W.; Tombari, F.; Navab, N.; Ilic, S.; Lepetit, V. “Hashmod: A Hashing Method for Scalable 3D Object Detection”. British Machine Vision Conference. 2015, p.36.1-36.12.

- 11)

- Hodan, T.; Zabulis, X.; Lourakis,M.; Obdrzalek, S.; Matas, J. “Detection and Fine 3D Pose Estimation of Texture-Less Objects in RGB-D images”. IEEE/RSJ International Conference on Intelligent Robots and Systems. 2015, p.4421-4428.

- 12)

- Hinterstoisser, S.; Cagniart, C.; Ilic, S; Sturm, P.; Navab, N.; Fua, P.; Lepetit, V. “Gradient Response Maps for Real-Time Detection of Textureless Objects”. IEEE Transactions on Pattern Analysis and Machine Intelligence. 2012, Vol.34, p.876-888.

- 13)

- Konishi, Y.; Hanzawa, Y.; Kawade, M.; Hashimoto, M. “Fast 6D Pose Estimation from a Monocular Image Using Hierarchical Pose Tree”. European Conference on Computer Vision. 2016, p.398-413.

- 14)

- Konishi, Y.; Hattori, K.; Hashimoto, M. “Real-Time 6D ObjectPose Estimation on CPU”. International Conference on Intelligent Robots and Systems. 2019, p.3451-3458.

- 15)

- Brachmann, E.; Michel, F.; Krull, A.; Yang, M,Y.; Gumhold, S.; Rother, C. “Uncertainty-Driven 6D Pose Estimation of Objects and Scenes from a Single RGB Image”. IEEE Conference on Computer Vision and Pattern Recognition. 2016, p.3364-3372.

- 16)

- Rios-Cabrera, R.; Tuytelaars, T. “Discriminatively trained templates for 3D object detection: A real time scalable approach”. IEEE International Conference on Computer Vision. 2013, p.2048-2055.

- 17)

- Hartley, R.I.; Zisserman, A. Multiple View Geometry in Computer Vision. Cambridge University Press. 2004.

- 18)

- Rusinkiewicz, S.; Levoy, M.; “Efficient Variants of the ICP Algorithm”. Proceedings Third International Conference on 3-D Digital Imaging and Modeling. 2001, p.145-152.

Intel® Coreは、Intel Corporationの米国およびその他の国における登録商標です。

本文に掲載の商品の名称は、各社が商標としている場合があります。