作業時間自動計測に向けた多様な工場環境に対応できる人位置検知技術

- インダストリアルエンジニアリング

- 生産性改善

- 時間計測

- 人検知技術

- 画像処理技術

近年の生産現場では、多品種少量生産の増加、定職率の低下による新人作業者の増加等、生産性や製品品質の低下に直結するバラツキ要因が増加している。バラツキ要因の特定には長期間の作業時間データが必要だが、現在はワークサンプリング法と呼ばれるサンプリング計測手法しかなく、リアルタイムに継続的に情報を収集できない。

そこで我々は、作業者が着用したカラーマーカーを、画像認識技術を用いて検知する人位置検知技術、およびその技術を用いた作業時間計測技術を開発した。一般的に画像認識を用いた位置検知では、環境変化による認識精度の低下が課題となる。そこで今回、環境が変化してもカラーマーカーを検知出来るような位置検知アルゴリズムを開発した。その結果、照明環境を変化させても、作業時間計測精度0.1秒未満の精度で最大6名の作業者を識別できることを確認した。

本技術を活用することで、作業者毎に作業時間バラツキが大きい工程や、想定よりも時間がかかっている工程の特定が容易になり、スピーディな課題解決につながる。

1. まえがき

近年の生産現場では、消費者ニーズの多様化による多品種少量生産の増加、定職率の低下による作業者の入れ替わり等により、生産性や製品品質の低下に直結するバラツキ要因が増加している。バラツキ要因の特定には生産中の設備や作業のデータが必要となるが、特に人の作業に関わるデータを自動で収集する手法は無い。人作業データを取得する方法として直接時間観察法(DTS)が知られているが、これは観測者が現場に赴いて作業者を観察しながら時間を計測する手法であり、効率が悪い。DTS以外にはワークサンプリング法と呼ばれる、観測時刻をランダム(無作為)に設定して作業内容を観察し、作業時間や内容を統計的に分析する手法も知られている1)。しかし、この手法でも、分析に最低1日以上が必要な上、設定した時間以外で発生したバラツキ要因は分析できない、という課題がある。

この問題の解決を目指して、作業時間の自動計測技術が多く提案されている。提案の1つに、人作業認識技術がある。これは、AIを用いて動画像から作業者の手や指の動きを分析し、人の作業工程を認識する手法である2-4)。作業認識技術は詳細な作業分析ができる反面、カメラを1-2 m間隔で設置する必要があり、導入工数が課題となっている。

この他にも作業時間を自動計測する他の手法として、工程の滞在時間を作業時間として計測する手法が提案されている5)。これは、作業者の位置を計測し、工程毎の作業領域に滞在する時間を計測するものである。これに必要な人位置の計測手法としては、無線(UWB帯)を用いるものや、カメラを用いた人画像認識を用いる手法が知られている。

しかし、無線を用いる手法では、導入時にアンテナの設置やキャリブレーションに時間を要するという課題がある。また、人画像認識は人の識別が一般的に斜め上から全身を撮影するため、人の識別が出来ないことに加え、作業者が設備や他の作業者に隠れると検出できないという課題がある。

以上の課題を解決する技術として、本稿では高精度かつ短期間で現場への導入が可能な人位置計測技術を紹介する。

まず、2章で従来技術の課題の詳細を説明する。3章では開発した人位置計測技術の詳細を説明し、4章で技術の原理検証(識別精度検証)結果について述べる。5章では、この技術を工場の生産ラインに導入し、時間計測の効果検証を行った結果について述べ、6章で今後に向けた課題と展望を述べる。

2. 課題

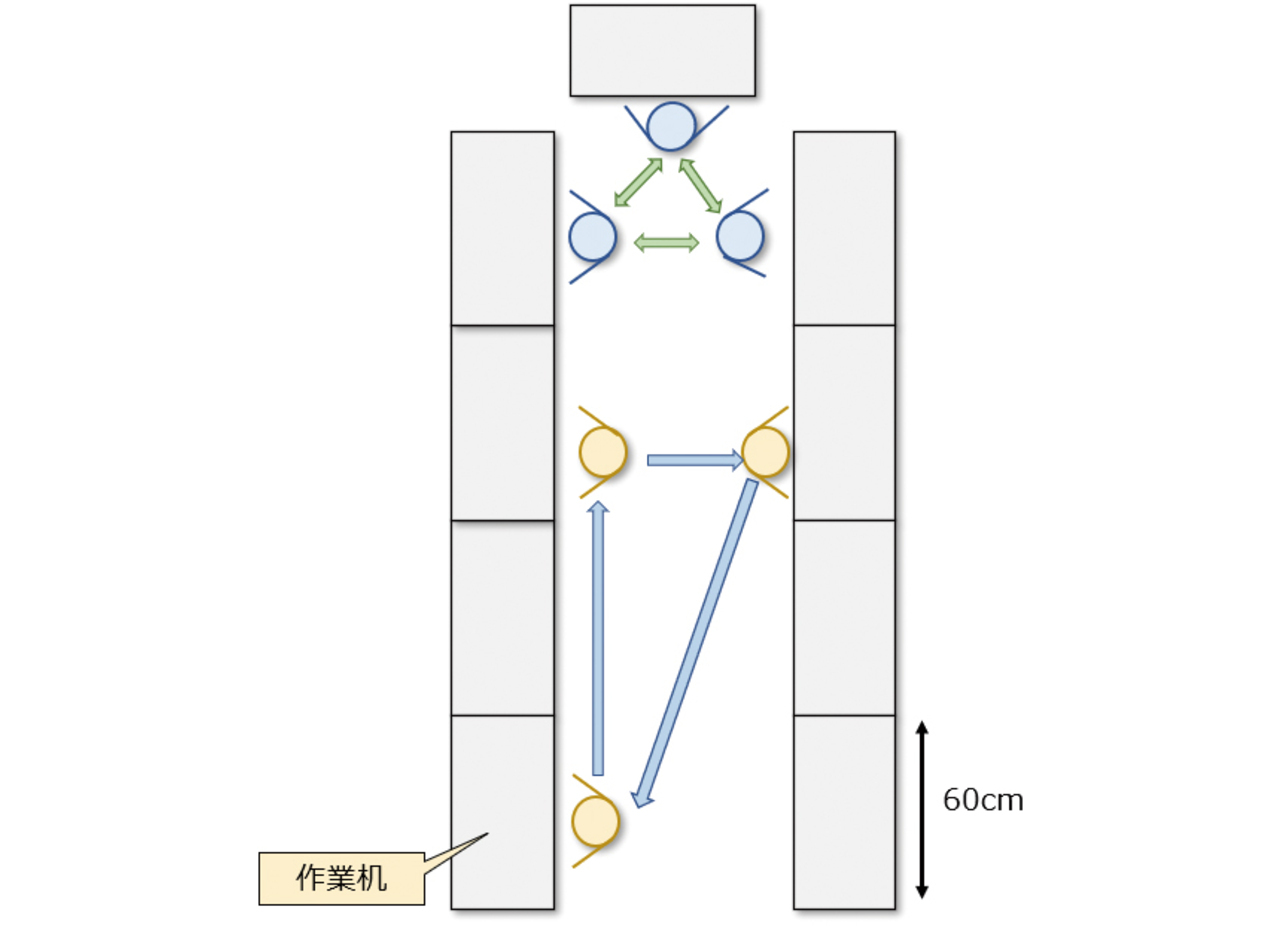

2.1 対象とする生産方式

本稿では作業者が複数の領域を移動しながら作業する工程を対象とする。具体的にはセル生産方式や装置の多台持ち工程を想定している。図1にセル生産方式(U字)の一例を示す。セル生産方式は、電子部品や自動車の組立工程で用いられている生産方式であり、生産量に応じて一人もしくは数人の作業者が分担して作業する。作業台の幅は60 cm程度、各工程の作業は凡そ5~20秒で行われる。それぞれの作業者の移動範囲は最大15 m程度を想定している。

2.2 人位置自動計測に求められる要件

2章1節で示した工程において人の作業時間を自動で計測するためには、人位置計測技術に以下の機能及び性能が求められる。

1)位置計測精度

位置計測は作業台の幅より十分に高精度である必要があるため、許容される誤差は10 cm未満である。精度の計測範囲は、一般的なセル生産ラインが十分収まるエリアとして、15 m×5 mを対象とした。

2)作業時間計測精度

人作業は1工程につき少なくとも1~2秒ばらつく。そこで計測精度は人作業のバラツキよりも充分小さくする必要がある。

3)人の識別

セルラインでは、同じ作業領域で複数の作業者が作業するため、測位とともに人の識別が求められる。この識別はラインへの頻繁な人の出入りや、姿勢の変化、照明の明るさなどの作業環境の変化に対応できる必要がある。

4)導入の容易さ

計測を始める前にはキャリブレーションなどの前処理が必要となる。工場は照明環境、ラインレイアウトが異なるため、一般的に計測前にキャリブレーションが必要となるため、短時間で導入出来る必要がある。

2.3 既存技術の課題

従来の人位置計測技術である、無線電波方式と、人認識AI方式に分けて説明する。

1)無線電波方式

無線電波方式としては、人工衛星を用いるGPS測位、Wi-Fiアクセスポイントを用いるWi-Fi測位、ビーコン端末を用いるBluetooth測位、無線(UWB帯)による三角測位、等が知られている。

このうち、GPS, Wi-Fi, Bluetoothの測位誤差は数m以上のため、我々が目指すセル生産での作業机レベルでの移動の計測はできない。

無線を用いた三角測距では、数十cm以内の誤差で測位可能である6)。しかし、UWB測位は導入に時間を要する。これは、電波の遮蔽や反射影響を除去するための受信機の位置調整というキャリブレーション作業や、高所での設置や配線作業が必要になるためである。これらの作業を完了させるには少なくとも1日以上を必要とする。また、無線方式では作業時間のボトルネックは特定できても、そのときの現場の具体的な状況が視覚的にはわからないため、改善へのフィードバックにつながりにくいという問題点がある。

2)人認識AI方式

人認識AI方式は、学習した人認識モデルを用いて画像に映る作業者を検出する手法である。この方式は車両の自動運転での歩行者検知等で活用されており、人の全身が映る場合に高い精度で検知できる7)。一方、一般的に個人の識別ができない上、セル生産方式では、作業者が設備や他の作業者に隠れると検出できなくなる問題がある。それを解消するための1つの策として、セルラインの真上の天井から真下に向けて撮影することで、作業者を映すことは可能になるが、頭頂部しか映らないため、人認識AIでは検知精度が低下する。

3. 提案手法

2章で述べたように、現状では、作業者の位置計測に必要な測位精度、検出精度、人の識別、導入容易性を満たす技術が無い。

そこで我々は複数色のカラーマーカー(色帽子)を用いた人位置検知技術を開発した。このような、カラーマーカーを用いた位置検出手法は画像認識で古くから知られている。一例として、あらかじめ設定した特徴物体をトラッキングする手法が挙げられる8)が、類似色の誤検知や、照明の明るさによる精度低下が発生する。本開発では、工場での作業時間計測に特化したアルゴリズムと設定ツールを用いることでこの問題を解決している。表1に想定した工場環境とその対策の一覧を示す。

| 変動要因 | 工場環境の特性 | 対策(色検知技術) | |

|---|---|---|---|

| 照明 | 色 | 初期値は現場毎に異なるが、時間変化はない | 初期設定容易化ツール(ゲイン・色調調整) |

| 照度 | |||

| 類似色 | 床色 |

色検知アルゴリズム開発 1.複数色設定 2.トラッキング補正 3.サイズ指定 |

|

| 機材 | 存在する | ||

| 作業者の姿勢変化 | 天井から作業者の距離はほぼ一定 | ||

| ライン規模 | 2 m-15 m | 複数カメラの連動 | |

更に我々は、照明の色/明るさは工場毎に異なるが、時間による変化はほぼ一定のため、初期設定を容易化するツールを開発した。類似色との誤検知については、色検知アルゴリズムの改良、およびトラッキング補正によって対策した。以下3章1節ではアルゴリズムの改良について、3章2節ではツール化の概要を紹介する。

3.1 色検知アルゴリズム

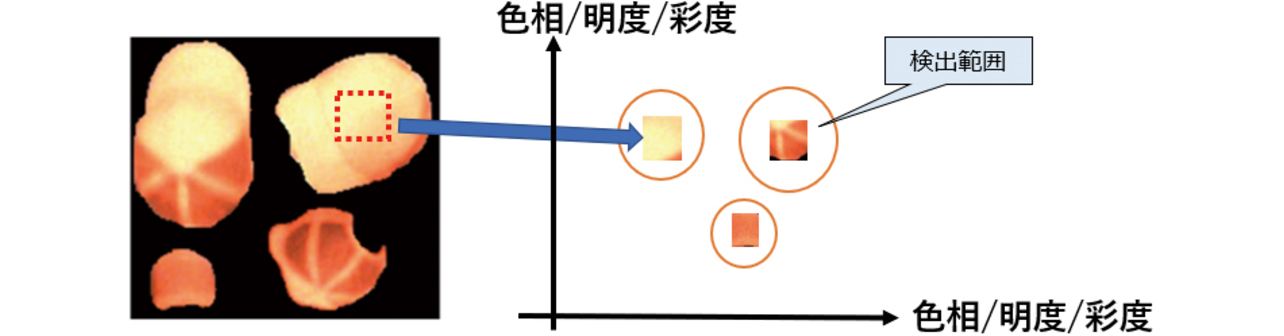

1)複数の色検知範囲設定

一般的な色検知では、1色当たり1つの検知範囲をHSV色空間(Hue:色相、Saturation:彩度、Value:明度から構成される座標系)に設定する。しかし生産現場では、スポット照明や周辺の照明のオンオフ等の影響により、場所によってHSVの値が変動し、これが色検知精度を低下させる。加えて、機材やワークに色帽子と同系色の物があると誤検知に繋がる。これを解決するため、我々は、HSVの値が変動してもその値は複数のクラスタによって分類できると考え、色帽子の色変動に合わせて検知範囲を複数設定した。具体的には、事前に現場で撮影した色帽子のHSV値をK-means法を用いて分類することにした。この手法は、近い場所にあるデータは同じクラスタであるという考えのもと、データ間の距離に基づいてクラスタリングを行う手法である。

図2で、橙色帽子での検知範囲設定のイメージを示す。この例では帽子の色相や明るさの変動に合わせて検知範囲を3つ設定している。

2)色帽子の検知結果の補正

検知精度の低下は、前章で記載した照明色や照度変化以外に、作業者のしゃがみ込みなどの姿勢変化や、隣り合う作業者の影に隠れることによる未検知が発生する。そこで人の動きを追跡して動く方向を予測し、検知結果を補正することにした。予測にはオプティカルフローを用いた。具体的には、色検知実行時に以下のステップを常時実行して補正を実施することとした。

- 過去に検知した位置と現在の位置から帽子の移動方向を予測する。

- 帽子を検知しなかったとき、予測した移動方向上に検知を補完する。

- 予測から明らかに外れた位置の検知結果は除外する。

この手法は追跡対象加えて、作業者の位置検出に特化しているため、完全に静止している物体を検知しない補正により、誤検知を防止にも活用した。

3.2 初期設定ツールを用いた導入容易化

画像認識の専門スキルが無くても短期間で導入できる仕組みとするため、以下機能を備えた設定ツールを開発した。

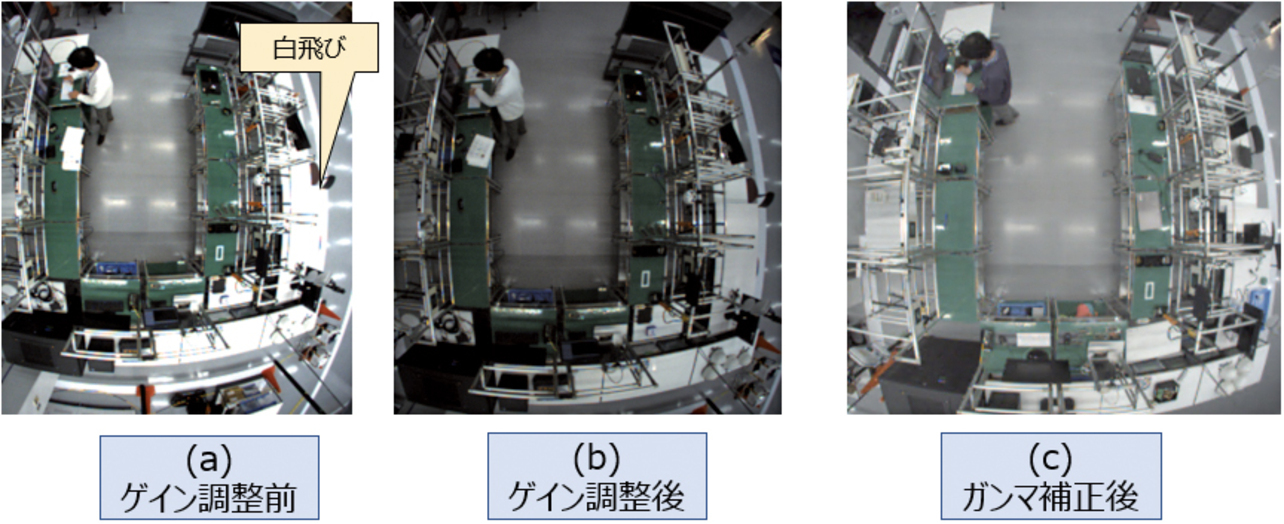

1)カメラのゲイン調整

人にとって視認性が高い状態で撮影すると白飛びが発生し、作業計測精度が低下する(図3(a))。そこで、白飛びが発生しないよう意図的にカメラのゲインを下げることとした。具体的には、設定する作業者がカラースペクトルを確認しながら、白飛びしないゲインに調整する機能をツール化した(図3(b))。結果としてゲイン調整が、専門知識が無くても短時間で設定できるようになった。

なお、このツールは色検知の後に、ガンマ補正して保存することで、工程改善に活用できる視認性を確保する(図3(c))。

2)色調補正

3章1節で記載の色検知範囲の設定もツール化した。具体的には以下の作業をボタン操作だけで実行し、色範囲を設定できるようにした。

- ① カメラのホワイトバランスを調整

- ② 色帽子を着用してライン内を歩く(1色当たり1分程度)様子を録画

- ③ 撮影した映像に映る色帽子のHSV値をクラスタ分類し、色検知範囲を複数設定

- ④ 設定した検知範囲に基づく色帽子の検知結果を、動画を再生しながら確認

結果として、色検知範囲の設定が短時間でできるようになった。

以上、専門知識がなくても、初期設定が短時間で行えるようになった。また、1台のPCで最大3台までカメラを連携できる仕組みを併せて持たせることで、1台のカメラでカバーできない比較的広いセルラインにも対応できるツールとした。

4. 色検知アルゴリズムの検証

3章で述べたアルゴリズムとツールの効果を以下の方法で、実験室環境で検証した。

4.1 検知範囲と作業者の識別

まず、検知範囲と精度を検証した。検証では8色の帽子を用いて、カメラ直下から3 m以内の6地点で姿勢を3種類(直立/前かがみ/しゃがみ込み)変えた合計18項目で誤検知と検知の有無を検証した。カメラは魚眼カメラを用い、天井の高さは3 m、身長は1.7 mとした。作業者の位置は帽子の色を検出した矩形の中央としている。色ごとのカメラ直下からの距離と、誤検知や未検知が発生した件数を実験した結果を表2に示す。

| 2 m | 2.5 m | 3 m | |

|---|---|---|---|

| 青緑 | 0 | 0 | 3(未検知) |

| 橙 | 0 | 0 | 0 |

| 桃 | 0 | 0 | 0 |

| 黄 | 0 | 0 | 3(未検知) |

| 黄緑 | 0 | 0 | 3(未検知) |

| 緑 | 0 | 0 | 3(未検知) |

| 赤 | 0 | 4(誤検知) | 4(誤検知) |

| 紫 | 6(未検知) | 6(未検知) | 3(未検知) |

赤色、紫色以外の6色はカメラ中心より2.5 m以内で誤検知、未検知なく検知できることを確認した。3 m離れると多くの色で未検知が発生した。これは、魚眼カメラの特性上、カメラ直下から離れるに従い帽子が小さく映ることで、未検知が発生しているためである。また、2.5 mの範囲でも赤色は4地点で誤検知が発生し、紫色は全ての地点で未検知となった。

次にこうした誤検知・未検知の発生要因について考察する。そのために、それぞれの色のHSV値を測定した結果を表3に示す。

| 色 | H(色相) | S(彩度) | V(明度) |

|---|---|---|---|

| 青緑 | 196 | 171 | 68 |

| 橙 | 12 | 206 | 204 |

| 桃 | 2 | 183 | 117 |

| 黄 | 37 | 165 | 130 |

| 黄緑 | 66 | 129 | 159 |

| 緑 | 114 | 108 | 83 |

| 赤 | 7 | 207 | 115 |

| 紫 | 228 | 94 | 55 |

赤色と桃色では、色相の値の差が5、明度の差2しかないため、誤検知に繋がったと考えられる。紫色は彩度と明度が他の色に比べ低く、検知自体が困難であったと考えられる。一方、橙色と桃色は検知可能だったため、色相差が10あれば検知可能と考えられる。

以上、5 m×5 mの範囲で6色の識別ができることから、我々の想定する多くの生産方式での作業者の識別ができると考えている。大規模なラインで作業者が7名以上となる場合は、同一色の帽子を使用し、作業位置とトラッキング補正をすることで、認証可能と考えている。

4.2 多様な環境への対応

多様な環境への対応は、照明色と照度の影響を評価した。検証には識別が可能な6色を用いた。

1)照明色

3章2節に記載の通り、カメラのホワイトバランス調整によって照明色による色帽子の色相変化を最小化している。表4に、各照明色におけるワイトバランス調整後のHSV値の代表例として色相差が小さい橙色と桃色を示す。

| 色 | 色温度[K] | H(色相) | S(彩度) | V(明度) |

|---|---|---|---|---|

| 橙 | 2700 | 17 | 186 | 228 |

| 5000 | 16 | 189 | 214 | |

| 桃 | 2700 | 7 | 164 | 172 |

| 5000 | 4 | 168 | 169 |

橙色、桃色ともに色温度の変化に対して色相の変化は最大3であった。これは橙色と桃色の色相差(10)に比べて充分小さくなっている。他色でも同様の傾向を示しており、結果として、照明色を変化させても誤検知・未検知は発生しなかった。

2)照度

3章2節に記載の通り、照度の影響はカメラのゲイン調整によって最小化している。表5に、照度を変化させたときの、ゲイン調整後のHSVの値を示す。

| 色 | 照度[Lux] | H(色相) | S(彩度) | V(明度) |

|---|---|---|---|---|

| 橙 | 530 | 16 | 220 | 168 |

| 700 | 16 | 218 | 180 | |

| 820 | 16 | 221 | 181 | |

| 桃 | 530 | 4 | 175 | 132 |

| 700 | 7 | 186 | 123 | |

| 820 | 4 | 177 | 145 |

橙色、桃色ともに照度の変化に対して色相の変化は最大3であり、橙色と桃色の色相差(10)に比べて充分小さくなっている。照明色との場合と同じく、他色でも同様の傾向を示しており、結果として、照明色を変化させても誤検知・未検知は発生しなかった。

以上の検証により、照明色や照度の変動があっても、我々の開発したアルゴリズムおよびツールを用いることで、誤検知や未検知のなく検知できることを確認した。

4.3 位置計測精度

次に位置計測精度を検証した。検証は、2章1節で述べた広さの実験用セルライン環境で行った。カメラ直下とラインの左右奥と左右手前(カメラ直下から2.5 m四方の地点)の5地点で30秒間色帽子を固定して計測し、計測位置のバラツキを計測した。ピクセル単位でのバラツキ(X,Y)と、それを長さに換算した結果を表6に示す。

| バラツキ (ピクセル値) |

バラツキ (長さ[cm]) |

|||

|---|---|---|---|---|

| X | Y | X | Y | |

| 直下 | 2.1 | 2.1 | 1.7 | 1.7 |

| ライン左奥 | 4.0 | 0.6 | 0.0 | 0.5 |

| ライン右奥 | 0.0 | 0.0 | 0.0 | 0.0 |

| ライン左手前 | 0.0 | 0.4 | 0.0 | 0.3 |

| ライン右手前 | 0.0 | 2.4 | 0.0 | 2.1 |

全ての地点でバラツキは5 cm未満であり、位置計測精度の要件を満たすことを確認した。

4.4 まとめ

以上の検証により、セル生産方式を代表とする人生産における作業時間計測に十分な作業者の識別、多様な環境への対応、および位置計測精度を満たすことが分かった。

5.作業時間計測検証

次に、工場の生産現場に導入して、導入容易性と作業時間計測の精度を検証した。

5.1 導入容易性の検証

3章2節で述べたツールを用いて実際に初期設定に要した時間を計測した。その結果、カメラ1台当たりゲイン調整に3分、色調補正に10分を要した。従って短時間で導入できると考えている。

5.2 作業時間の計測

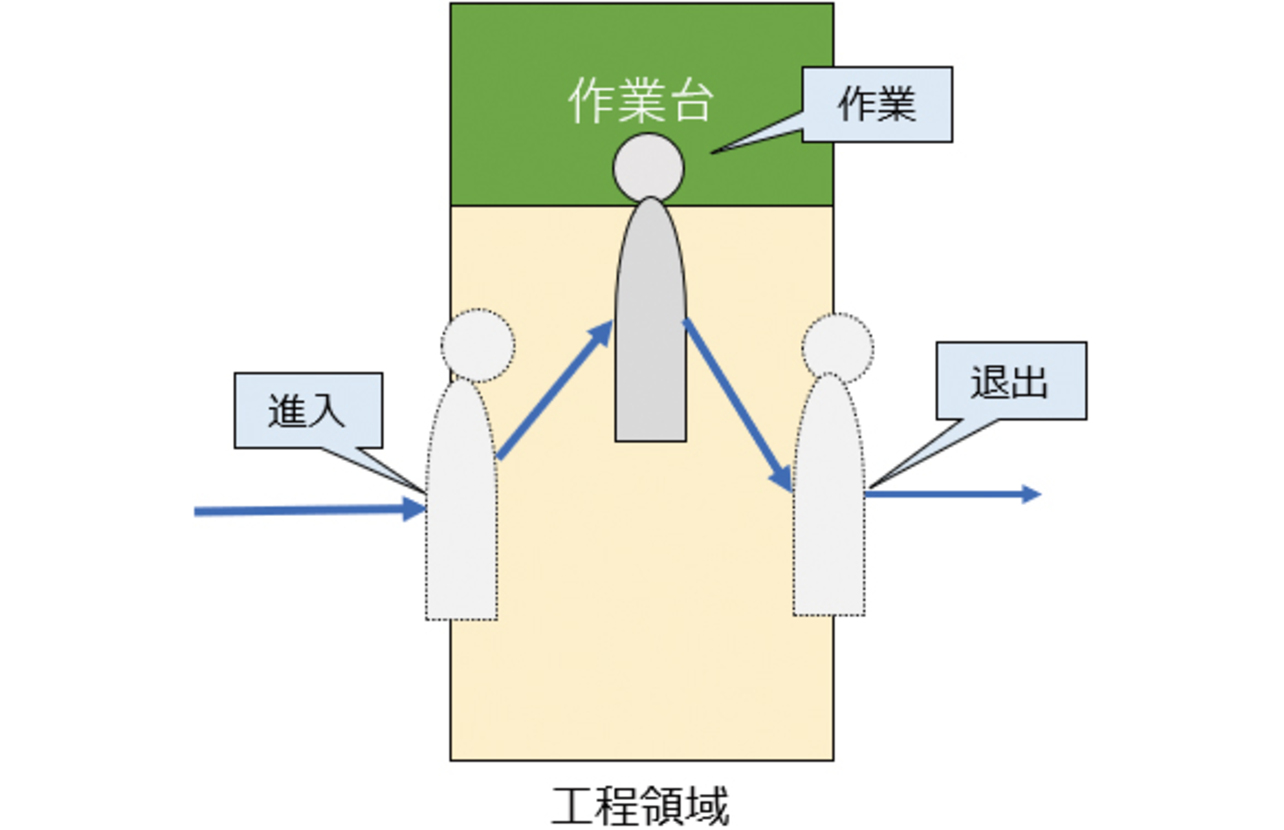

検証は4名で生産するセル生産のラインで実施した。作業領域は60 cmの作業机毎に10領域設定し、各領域内の滞在時間を作業時間としてみなした。ここでいう滞在時間とは図4で示すように領域に侵入してから、作業台で作業し、退出するまでの時間である。作業時間計測精度は、ストップウォッチを用いた目視確認の結果との比較により評価した。

5.3 検証結果

自動計測した作業時間と、目視計測結果を比較した結果を表7に示す。

| サイクル | 自動計測した 作業時間(秒) |

目視確認(秒) | 誤差 |

|---|---|---|---|

| 1 | 8.14 | 6.90 | 1.24 |

| 2 | 9.05 | 7.80 | 1.25 |

| 3 | 9.44 | 8.30 | 1.14 |

| 4 | 9.14 | 7.92 | 1.22 |

| 5 | 7.88 | 6.67 | 1.21 |

| 6 | 8.49 | 7.29 | 1.20 |

| 7 | 7.88 | 6.66 | 1.22 |

| 8 | 8.18 | 6.97 | 1.21 |

| 9 | 7.61 | 6.41 | 1.20 |

| 10 | 7.92 | 6.70 | 1.22 |

全てのサイクルで本手法による作業時間が目視確認に比べて1.1~1.2秒長い結果となった。その要因は、目視確認作業時間が作業台での作業開始から終了までであるのに対して、本計測では目視確認の作業時間に加え、領域に入ってから作業台まで、および作業終了後に領域を出るまでの時間が含まれるためである。

このように、自動計測した作業時間と目視確認の作業時間との間には1秒以上の差分が発生している。しかし我々は、それらの差分がすべてのサイクルで一定時間であることに着目した。つまり、生産現場では移動速度は作業時間によらず一定のため、本手法による計測時間から差し引くことで、従来手法と同精度(誤差±0.1秒未満)で作業時間計測が可能になる。このように人の作業時間バラツキよりも充分に計測誤差が小さいため、この手法は人作業の計測に活用できる。

6. むすび

我々は、人作業時間の自動計測の実現を目指して、カラーマーカーを用いた人位置検知技術を開発した。具体的には、作業者を天井から撮影し、画像に映るカラーマーカーの位置を検知する。検知アルゴリズムとしては、クラスタリング法を用いたマーカ色の複数検知範囲設定や、オプティカルフローを用いた人位置の補正などのアルゴリズムを開発することで、照度、照明色の変化や、作業者の姿勢変化があっても検知出来るようにした。また、現場にあわせたキャリブレーション等の初期設定をツール化したことで、様々な工場環境に簡単に導入できるようになった。

本技術の導入効果として、生産中すべての作業時間がリアルタイムに取得出来ることで、品質不具合につながる標準外作業や、熟練者と初心者の作業時間バラツキ等の情報が得られる。これらの情報を元に適切な業務変更を実施することで、バラツキ要因が増加する中でも生産性/品質の安定化が実現できることが期待される。今後、得られた情報を作業者にフィードバックすることにより、作業者の習熟やモチベーションの向上に繋げられると考えている。

以上、現場主導での素早い変化対応に加え、作業者自身がスキルアップを実感できるワクワクする製造現場の実現に向けた技術の開発に取り組んでいく。具体的には、計測した作業時間を用いてボトルネックを可視化・分析する技術や、作業者の異常な挙動を検知する技術を検討していく。

参考文献

- 1)

- W.-H. Tsai, “A Technical Note on Using Work Sampling to Estimate the Effort on Activities Under Activity-Based Costing,” Int. J. Prod. Econ., vol. 43, issue 1, pp. 11-16, 1996.

- 2)

- 奥村誠司 他, “作業分析ソリューション“骨紋”,” 三菱電機技報, vol. 94, no. 6, pp. 352-355, 2020.

- 3)

- 西田一貴, 音田浩臣, “セル生産ラインにおける作業者の標準外動作検知システムの開発,” システム制御情報学会論文誌, vol. 33, no. 5, pp. 149-155, 2020.

- 4)

- 株式会社ライブラリー. “3次元動画計測ソフトウェア.”Cosmos. https://www.library-inc.co.jp/product/?id=1372147489-429207&ca=11&list_flg=1(Accessed: Mar. 6, 2024).

- 5)

- オムロン株式会社, “データ抽出装置、データ抽出装置の制御方法、情報処理プログラム、及び記録媒体,” 特開2020-205027, Dec. 24, 2020.

- 6)

- F. Mazhar et al., “Precise Indoor Positioning Using UWB: A Review of Methods, Algorithms and Implementations,” Wireless Pers. Commun., vol. 97, pp. 4467-4491, 2017.

- 7)

- 福井宏 他, “Deep Learningを用いた歩行者検出の研究動向,” 電子情報通信学会技術研究報告=IEICE technical report: 信学技報, vol. 116, no. 366, pp. 37-46, 2016.

- 8)

- 株式会社ライブラリー. “2次元動画計測ソフトウェア.” Move-tr/2D. https://www.library-inc.co.jp/product/?id=1372146225-105767&ca=11&list_flg=1(Accessed: Mar. 6, 2024).

本文に掲載の商品の名称は、各社が商標としている場合があります。