非剛体物体・不規則形状物体ピッキングのためのモデルレス把持位置認識

- ビンピッキング

- 把持位置認識

- ロボット

- 3次元認識

- 距離画像処理

本稿では、ロボットがコンテナにバラ積みされている物体をピッキングするための、把持位置認識を扱う。通常、把持対象物体の三次元CADを用いることで把持位置を認識するが、特定の三次元CADが存在しない非剛体物体・不規則形状物体では認識が困難になる。非剛体物体・不規則形状物体のピッキングを実現するため、三次元CADを用いずに把持位置を認識することを可能にするモデルレス把持位置認識を提案する。二指ハンド向けの提案手法では、左指・右指に対して独立に挿入候補を検出し、組み合わせることで複数の開き幅の把持候補を高速に認識する。吸着ハンド向けの提案手法では、距離画像の局所的な物体面の方向に基づいて平面領域を抽出し、最適な把持位置を認識する。提案手法を用いて、実際にロボットで非剛体物体および不規則形状物体のピッキングを行ったところ、二指ハンドおよび吸着ハンドの両方で96%以上の把持成功率を達成した。また、処理時間はIntel(R)Core(TM)i7-7700 @3.60GHzのCPU上でいずれも250msec以内であり、リアルタイムの高速なピッキングを可能にする。

1.まえがき

製造現場や物流倉庫において、物体をピッキングし、所定の場所へ移動させる作業を人が担うことが数多く存在する。例えば、自動車工場において生産ラインに部品供給する際には、コンテナ内にバラ積みされている部品を作業員が一つずつピッキングする。このようなライン生産方式は、多くの作業員を必要とし、その中には部品のピッキングのような単純作業のみを担当する作業員も存在する。一方、近年は労働人口不足が深刻化しており、このような単純作業を機械で置き換えて自動化する需要が高まってきている。自動化するための方法の一つとして、パーツフィーダと呼ばれる部品供給専用の装置を用いることがある。しかし、パーツフィーダは部品毎で専用に設計される特注品であるため、生産ラインの立ち上げ工数が増加してしまう課題がある。これに対して、1台の汎用ロボットを用いてバラ積みされた様々な部品をピッキングし、供給を自動化することで、立ち上げ工数を短縮することが可能となる。

バラ積みピッキングを実現するには、把持対象物体を撮影した画像/距離画像からロボットの最適な把持位置を認識する必要がある。工業用部品のような剛体をピッキングする場合、三次元CADモデルを用いて把持物体の位置・姿勢を認識する1,2)。しかし、ケーブルや袋物など形状が変化する物体(非剛体物体)や食品や農作物のような個体ごとに形状が異なるような物体(不規則形状物体)では特定の三次元CADモデルが存在しないため、把持物体の位置・姿勢を認識することが困難となる。これに対して、物体の位置姿勢を認識することなく、すなわち把持対象物体のモデルを必要とせず、ハンドの形状と計測データから直接、把持位置姿勢を認識するモデルレス把持位置認識が有効である。非剛体物体や不規則形状物体においてその物体の種類や姿勢の推定を必要とする場合、モデルレス把持位置認識を前段処理として使うことになるため安定した把持位置を認識しつつ高速な処理速度が求められる。

本研究では、非剛体物体や不規則形状物体の把持を対象とした高速なモデルレス把持位置認識手法を提案する。産業用ロボットに使われる一般的なハンドとして、二指ハンドと吸着ハンドが存在するが、本研究はそれぞれのハンドを対象とした手法を提案する。二指ハンドと吸着ハンドの例を図1に示す。

2. 関連研究

モデルレス把持位置認識には、把持物体の最適な把持位置を学習によって推定する機械学習に基づく手法とロボットハンドのモデルを用いてハンド形状に適した把持位置を探索するハンドモデルに基づく手法に分けることができる。

2.1 機械学習に基づく把持位置認識

モデルレス把持位置認識では、事前に物体の情報が与えられないため、様々な物体の最適な把持位置をDeep Neural Network (DNN)により学習させる手法が多く提案されている3)-10)。Redmonらは入力画像を7×7で分割したグリッドとDNNから出力される7×7の特徴マップを対応付け、特徴マップの各画素から二指ハンドの把持中心座標、幅・高さ、回転角度、把持信頼度の6次元データを回帰により算出する手法を提案した6)。把持領域の推定をFully Convolutional Network(FCN)によるセマンティックセグメンテーションによる分類問題として解く手法も提案されている7),8)。Dex-Net 3.0/4.09),10)では、把持位置周辺のパッチ画像に対して把持の頑健性を確率で出力するDNNを学習する。これらの手法のようにDNNを用いることで、高精度な把持位置を認識することが可能となるが、教示付きの大量の学習画像や高スペックな計算マシンが必要となるため導入が困難となる場合がある。

2.2 ハンドモデルに基づく把持位置認識

機械学習を必要としない把持位置認識手法としてロボットのハンド形状に基づいて画像から把持位置を探索する手法がある。Fast Graspability Evaluation(FGE)11),12)では、距離画像内の物体セグメントにハンド形状を表現した2次元バイナリ画像を畳み込むことで高速に把持位置を探索する。FGEを二指ハンドに適用する場合、非剛体物体や不規則形状物体では、個体ごとに大きさが異なるため、複数のハンド開き幅での把持位置探索が必要になり、開き幅の数だけ計算時間が増加してしまうという課題がある。FGEを吸着ハンドに適用する場合、抽出する物体セグメントには平面らしさが考慮されておらず、凹凸が存在するセグメントを吸着把持し、把持成功率が低下してしまうという課題がある。

本研究では、大量の学習画像を用意する必要がないというメリットにより、ハンドモデルに基づく把持位置認識を選定し、前述したFGEの課題を克服するモデルレス把持位置認識手法を提案する。二指ハンドと吸着ハンドの最適な把持位置を同一のアルゴリズムで定義することが困難であるため、本研究では二指ハンド向けモデルレス把持位置認識と吸着ハンド向けモデルレス把持位置認識をそれぞれ別のアルゴリズムとして提案する。

3. 二指ハンド向けモデルレス把持位置認識

3.1 アルゴリズムの概要

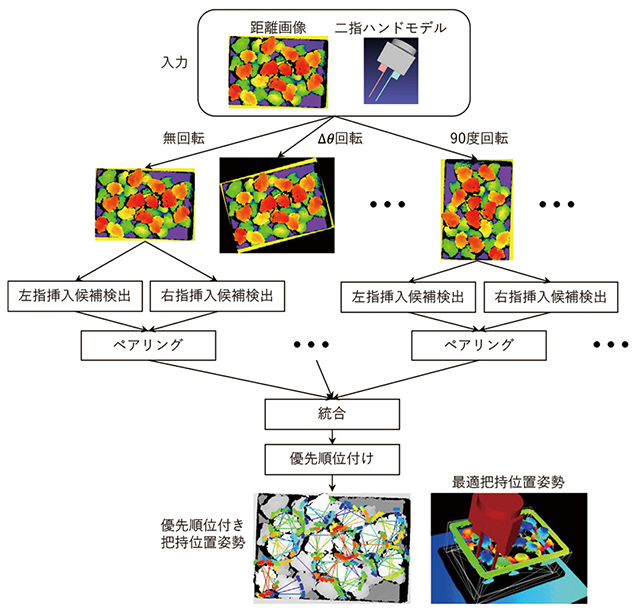

食品等のような非剛体物体や不規則形状物体では、個体ごとに大きさが異なるため、二指ハンドで把持位置を認識する際には複数のハンド開き幅での探索が必要になり、開き幅の数だけ計算時間が増加してしまう。この問題に対して、本研究では二指ハンドの左指および右指の各々に対して独立に挿入候補を検出し(単指挿入候補検出)、左指挿入候補と右指挿入候補をペアリングすることで、複数の開き幅の把持候補を高速に認識する。図2にアルゴリズムの全体像を示す。からあげのバラ積みを例として用いる。三次元センサで計測した距離画像から把持位置を認識する。三次元センサの光軸回りに対する様々な方向からの把持候補を探索するために、

3.2 単指挿入候補検出

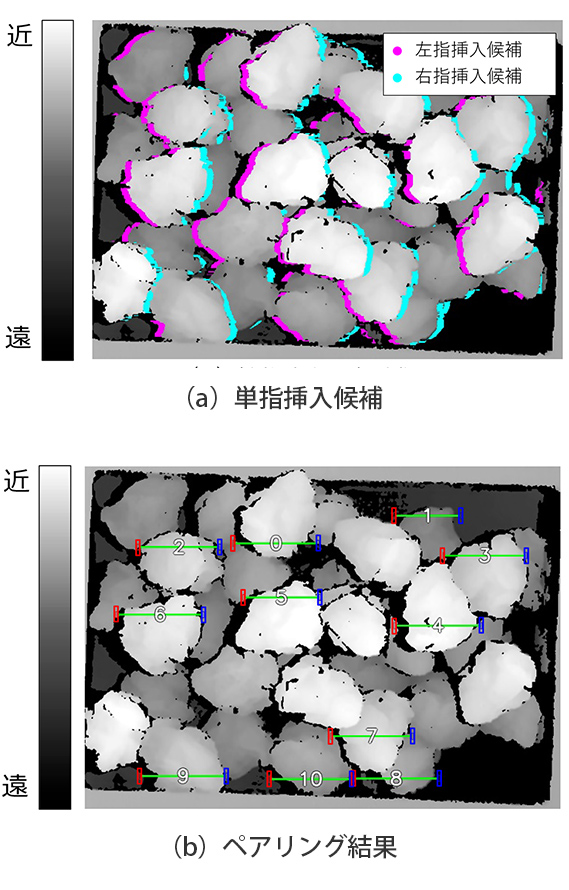

二指ハンドの左指および右指を挿入可能な候補位置をそれぞれ独立に検出する。二指ハンドにより物体を安定して把持するためには、以下の二つの把持条件が重要である。

1.物体を確実に把持するための十分な高さのエッジが存在する

2.指を挿入したときに干渉を起こさない十分なスペースが存在する

これらを満たす単指挿入候補を検出する。まず、距離画像に水平方向の微分フィルタを適用し、水平方向の距離エッジ強度を算出する。距離エッジ強度の絶対値が一定値以上の画素を取り出す。このとき、距離エッジ強度の符号が負の画素は、距離画像の

3.3 ペアリング

左指挿入候補と右指挿入候補をペアリングすることで把持候補を生成する。任意の左指挿入候補に対するペアリング対象となる右指挿入候補は、事前に距離画像を回転しているため、同じ

3.4 優先順位付け

複数の回転距離画像から探索した把持候補を統合し、優先順位が高い順に並べ替えを行う。「把持しやすさ」は、距離が近い、凸部高さが高い、把持部の直線性が高いなど様々な観点で定義できる。提案手法では、距離、凸部高さ、把持部の直線性の3種類の評価指標を組み合わせることで総合的な評価値を算出する。評価値が高い順に並べ替えることで優先順位付けを行う。

4. 吸着ハンド向けモデルレス把持位置認識

4.1 アルゴリズムの概要

吸着ハンドにより物体を安定して把持するには、以下の二つの把持条件が重要である。

1.確実な吸着を実現するために、実現把持物体の表面に対して垂直にアプローチ

2.吸着パッドからの空気漏れを起こさないように、把持物体の平面領域を吸着

これらの二つの吸着把持条件を満たすために、距離画像の法線ベクトルの分散に基づいて平面領域を抽出し、把持候補を認識する。法線ベクトルは三次元距離データの局所的な面の向きを表すベクトルである。そのため、法線ベクトルが周囲で同じ方向を向いている場合、すなわち分散が小さい場合は平面領域であると言える。把持位置におけるアプローチ角度は、平面領域抽出時に算出した法線ベクトルを再利用することができるため、複雑な計算処理を必要とせず、高速な把持位置認識が可能となる。

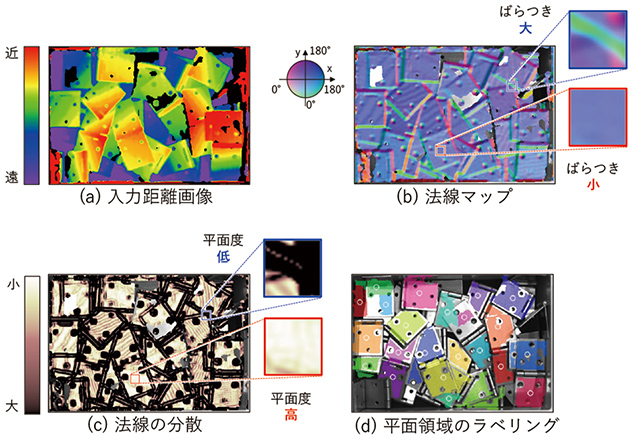

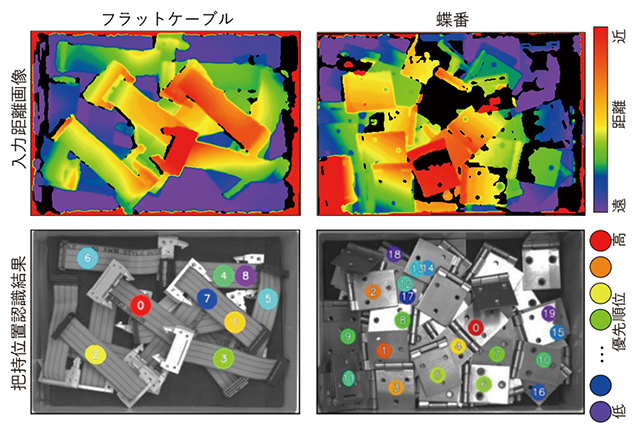

提案手法による吸着把持位置認識の流れとして、まず距離画像から物体の平面領域を抽出し、平面領域の各画素から把持のしやすさ(把持評価値)を算出する。次に把持評価値の高い位置における把持姿勢から、周囲の三次元点群とハンドモデルの干渉判定を実施し、把持候補として登録する。以降、図4(a)の蝶番のバラ積みの距離画像を例として、提案手法の詳細を説明する。

4.2 法線ベクトルの分散に基づく平面領域抽出

入力距離画像の局所矩形領域内の三次元距離データ(

平坦な領域は法線ベクトルのばらつきが小さくなり、凹凸がある領域は法線ベクトルのばらつきが大きくなる。従って、局所矩形領域内において、法線ベクトルの分散を算出する(図4(c))。そして、局所矩形領域内から算出した法線ベクトルの分散が所定の閾値以下である場合に平面ラベルを割り当て、平面領域のバイナリ画像を生成する。平面領域のバイナリ画像に対してラベリング処理を施し、ラベル付き平面領域を取得する(図4(d))。

以上の処理により、バラ積み物体の平面領域を抽出することができる。しかし、同じ高さの把持物体が隣接している状況が発生した場合、物体境界付近の距離値の変化が微小であるため、複数の物体平面を単一の物体平面として抽出してしまうアンダーセグメンテーション問題が発生する。そこで、ラベル付き平面領域画像に対してwatershed法13)による領域分割を適用する。watershed法は平面領域画像の距離変換処理、領域収縮、再ラベリング、ラベリング領域の膨張処理から構成される。距離変換は、平面領域の各画素に対して非平面領域から距離を計算する処理であり、非平面領域から距離が遠い平面画素は大きな値を持ち、非平面領域から距離が近い平面画素は小さな値を持つ画像となる。従って、距離変換値の小さな画素を平面領域から除外することで平面領域を収縮し、複数の物体の平面領域を分割できる。その後、収縮処理により分割した平面領域を再ラベリングし、ラベリングした平面領域を収縮前の元の領域サイズ、または平面領域同士が接触するまで膨張させる。この処理により、アンダーセグメンテーションを抑制することができ、正確な平面領域を抽出することができる。

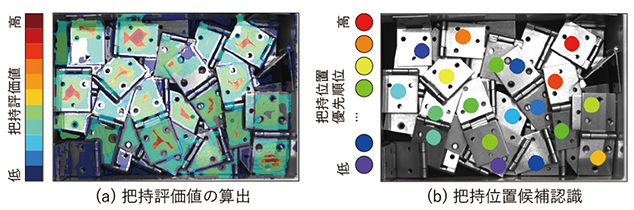

4.3 把持評価値による把持候補の認識

抽出された平面領域内から、把持しやすい位置を決定するために把持評価値を算出する。把持評価値は平面領域内の把持のしやすさを表すスコアであり、平面重心までの距離、法線の分散、把持アプローチ角度等、数種類の把持指標を統合して算出する。実際には、各種類の把持指標に閾値を設定し、各把持指標における把持しやすさを三値{A,B,C}に分類する。最終的な把持評価値はAの数が多いほど評価値が高く、Cの数が多いほど評価値が低くなるように割り当てる。この処理を平面領域内の全ての画素に対して実行する。図5(a)に把持評価値の算出結果を示す。法線の分散は平面抽出の際に算出済みであり、把持アプローチ角度は法線方向を利用するため別処理で計算する必要はない。よって、各平面領域における把持評価値を高速に計算することができる。

把持評価値を平面領域内の全画素で算出した後、把持評価値の高い画像座標から順番に把持姿勢を算出する。その後、算出した把持姿勢におけるハンドモデルと周囲の三次元点群との干渉判定を実施する。把持姿勢を算出する際のアプローチ角度は、平面領域抽出時に算出した法線ベクトルを再利用することで不要な計算を省くことができる。各座標位置で把持姿勢算出と干渉判定を繰り返し、干渉無しとして判定された時点でその座標位置を把持候補として登録する。この処理を全ての平面領域について実行する。各平面領域で登録された把持候補を図5(b)に示す。

4.4 優先順位付け

把持候補を算出後、把持候補に優先順位を付ける。基本的には、高い把持評価値を持つ把持位置に高い優先順位を付与する。しかし、同等の評価値を持つ把持候補が複数存在する場合がある。そのような場合は、平面重心までの距離、法線の分散、把持アプローチ角度等の把持指標から任意の指標を選択し、同じ評価値の把持候補をソートする。

5. 評価実験

5.1 評価方法

評価実験により、提案手法の有効性を確認した。バラ積み状態の把持対象物体を三次元センサで撮影し、撮影画像から把持位置を認識した。認識した把持位置を6軸垂直多関節ロボットでピックし、所定の場所へプレースを実施した。ロボットの駆動範囲内でかつ優先順位の高い把持位置に対してロボットが把持をトライする。ロボットが把持をトライした回数と、物体を把持して所定の位置へプレースできた回数の割合により把持成功率を算出して評価した。また、1枚の画像における把持位置認識の処理時間も評価した。把持位置認識処理はロボットがトライする前に毎回実行するため、1回の把持位置認識処理における平均処理時間を算出した。三次元計測センサにはiDS社製のEnsenso X36、多関節ロボットにはOMRON社製のViper650を使用した。Intel(R)Core(TM)i7-7700 @3.60GHzのCPUを搭載した計算機で処理時間を計測した。

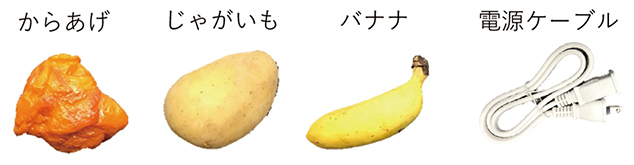

5.2 二指ハンド評価結果

二指ハンド向けモデルレス把持位置認識の評価実験で用いる把持対象物体は図6に示す大きさ・形状・材質等が異なる4種類の物体である。これのうち、からあげ・じゃがいも・バナナは不規則形状物体であり、電源ケーブルは非剛体物体である。

各把持対象物体における把持成功率および処理時間を表1に示す。

| 把持対象物体 | プレース回数/ トライ回数 |

把持成功率[%] | 処理時間[msec] |

|---|---|---|---|

| からあげ | 93/93 | 100.0 | 211 |

| じゃがいも | 159/160 | 99.4 | 285 |

| バナナ | 110/124 | 88.7 | 197 |

| 電源ケーブル | 39/40 | 97.5 | 221 |

| 平均 | 96.4 | 229 |

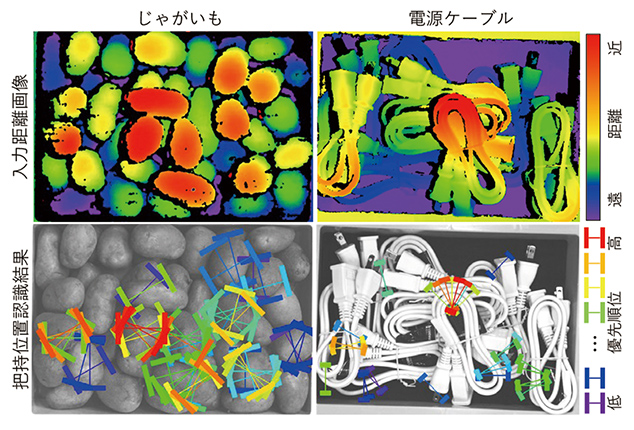

表1に示す結果から、平均96.4%と高い把持成功率を達成することができていることが確認できる。これは、最適な開き幅を認識することで、固定開き幅と比べて把持候補数を最大化できていることが貢献している。からあげやじゃがいものような球体に近い形状の物体は、様々な角度から安定して把持候補を見つけることができるため、特に把持成功率が高くなっている。バナナのみ88.7%と把持成功率が低くなっているが、物体端部のような不安定な部位の把持が起きやすかったことが原因である。処理時間については、平均で約229msecで把持位置認識できており、リアルタイムで高速なバラ積みピッキングが可能である。これは、単指挿入候補検出後にペアリングを行っているため、複数のハンド開き幅での把持位置探索を行う必要が無く、計算量を大幅に低減できていることが貢献している。図7に二指ハンドの把持位置認識の結果例を示す。

5.3 吸着ハンド評価結果

吸着ハンド向けモデルレス把持位置認識の評価実験で用いる把持対象物体は図8に示す大きさ・形状・材質等が異なる5種類の非剛体物体である。

各把持対象物体における把持成功率および処理時間を表2に示す。

| 把持対象物体 | プレース回数/ トライ回数 |

把持成功率[%] | 処理時間[msec] |

|---|---|---|---|

| フラットケーブル | 38/39 | 97.4 | 72 |

| ハンドソープ | 18/18 | 100.0 | 112 |

| マヨネーズ | 114/120 | 95.0 | 91 |

| プラスチックパーツ | 65/68 | 95.5 | 75 |

| 蝶番 | 73/75 | 97.3 | 67 |

| 平均 | 97.0 | 83 |

表2に示す結果から、全ての把持対象物体に対して95%以上の把持成功率であることが確認できる。平面らしさを考慮した平面抽出と適切な把持アプローチ角度の算出により、安定した吸着把持を実現した。特にハンドソープは、物体サイズが大きく、平面領域が比較的広いため高い把持成功率が得られた。把持に失敗する主な理由としては、マヨネーズ等の厚さが薄い物体において、距離画像上での物体境界の判別が困難となり、物体境界付近への把持アプローチが発生することである。また、プラスチックパーツは物体表面上に浅い溝が存在し、吸着時に空気漏れが発生し把持失敗することがあった。

処理時間については、平均で約83msecで把持位置認識できており、リアルタイムで高速なバラ積みピッキングが可能である。ハンドソープは画像から抽出される平面領域の面積が広いため、把持候補の探索や把持姿勢算出に多くの処理時間を要している。図9に吸着ハンド向け把持位置認識の結果例を示す。

6. むすび

本研究では、二指ハンド向けおよび吸着ハンド向けのモデルレス把持位置認識手法を提案した。二指ハンド向け把持位置認識では、二指ハンドの左指および右指それぞれに対して独立に挿入候補を検出し、左指挿入候補と右指挿入候補を組み合わせることで高速に複数の開き幅の把持候補を探索する。吸着ハンド向け把持位置認識では、物体を安定して吸着把持するために、距離画像の法線ベクトルの分散に基づいて平面領域を抽出し、把持候補を認識する。二指ハンド/吸着ハンドそれぞれの提案手法を用いて、非剛体物体および不規則形状物体のバラ積みを実際にロボットでピッキングしたところ、平均で96.4%/97.0%の把持成功率を達成し、Intel(R)Core(TM)i7-7700 @3.60GHzのCPU上で229msec/83msecという高速な処理を実現した。

今後の課題として、更なる把持成功率の向上が挙げられ、把持失敗原因に着目した対策が必要となる。また、提案手法では様々なパラメータが存在するが、現状は人手でチューニングを行っているため、自動チューニング機能を開発することで使用性を向上することも挙げられる。

参考文献

- 1)

- Konishi, Y.; Hanzawa, Y.; Kawade, M.; Hashimoto, M. “Fast 6D Pose Estimation from a Monocular Image Using Hierarchical Pose Trees”. Proceedings of European Conference on Computer Vision. 2016, p.398-413.

- 2)

- Konishi, Y.; Hattori, K.; Hashimoto, M.. “Real-Time 6D Object Pose Estimation on CPU”. Proceedings of International Conference on Intelligent Robots and Systems. 2019, p.3451-3458.

- 3)

- Lenz, I.; Lee, H.; Saxena, A. Deep Learning for Detecting Robotic Grasps. International Journal of Robotics Research. 2015, Vol.34, No.4-5, p.705-724.

- 4)

- Mahler, J.; Liang, J.; Niyaz, S.; Laskey, M.; Doan, R.; Liu, X.; Ojea, J. A.; Goldberg, K. “Dex-Net 2.0: Deep Learning to Plan Robust Grasps with Synthetic Point Clouds and Analytic Grasp Metrics”. Proc. Robotics: Science and Systems. 2017.

- 5)

- Caldera, S.; Rassau, A.; Chai, D. Review of Deep Learning Methods in Robotic Grasp Detection. Multimodal Technologies and Interaction. 2018, Vol.2, No.3, p.57-80.

- 6)

- Liang, H.; Ma, X.; Li, S.; Grner, M.; Tang, S.; Fang, B.; Sun, F.; Zhang, J. “PointNetGPD: Detecting Grasp Configurations from Point Sets”. Proceedings of International Conference on Robotics and Automation. 2019, p.3629-3635.

- 7)

- Redmon, J.; Angelova, A. “Real-Time Grasp Detection using Convolutional Neural Networks”. Proceedings of International Conference on Robotics and Automation. 2015, p.1316-1322.

- 8)

- Kusano, H.; Kume, A.; Matsumoto, E.; Tan, J. “FCN-Based 6D Robotic Grasping for Arbitrary Placed Objects”. Proceedings of International Conference on Robotics and Automation: Warehouse Picking Automation Workshop. 2017.

- 9)

- Mahler, J.; Matl, M.; Liu, X.; Li, A.; Gealy, D.; Goldberg, K. “Dex-Net 3.0: Computing Robust Vacuum Suction Grasp Targets inPoint Clouds Using a New Analytic Model and Deep Learning”.Proceedings of International Conference on Robotics and Automation.2018, p.1-8.

- 10)

- Mahler, J.; Matl, M.; Satish, V.; Danielczuk, M.; DeRose, B.;McKinley, S.; Goldberg, K. Learning Ambidextrous Robot Grasping Policies. Science Robotics. 2019, Vol. 4, No. 26. p.eaau4984.

- 11)

- Domae, Y.; Okuda, H.; Taguchi, Y.; Sumi, K..; Hirai, T. “Fast Graspability Evaluation on Single Depth Maps for Bin Picking with General Grippers”. Proceedings of International Conference on Robotics and Automation. 2014, p.1997-2004.

- 12)

- Mano, K.; Hasegawa, T.; Takayoshi, Y.; Fujiyoshi H.; Domae, Y. “Fast and Precise Detection of Object Grasping Positions with Eigenvalue Templates”. Proceedings of International Conference on Robotics and Automation. 2019, p.4403-4409.

- 13)

- Vincent, L.; Soille, P. Watersheds in Digital Spaces: An Efficient Algorithm Based on Immersion Simulations. Pattern Analysis and Machine Intelligence. 1991, No. 6, p.583-598.

本文に掲載の商品の名称は、各社が商標としている場合があります。